在 SC25 (全球超级计算大会) 上,NVIDIA 展示了在 NVIDIA BlueField DPU、新一代网络、量子计算、科学研究、AI 物理等领域的进展。加速系统正推动 AI 超级计算的新篇章。

作为加速吉瓦 (Gigascale – 十亿瓦) 级 AI 基础设施的 BlueField 全栈平台的一部分,

NVIDIA 还重点介绍了 NVIDIA BlueField-4 DPU 带来的存储创新。

此外,还详细介绍了 NVIDIA Quantum-X Photonics InfiniBand CPO 网络交换机,此交换机如何助力 AI 工厂大幅降低能耗和运营成本,TACC、Lambda 和 CoreWeave 均计划采用此交换机。

NVIDIA 创始人兼首席执行官黄仁勋惊喜现身 St. Louis 活动现场,并向出席 SC25 的观众分享了 NVIDIA 最新的超级计算进展。

“今年的重磅消息当属 Grace Blackwell 平台,大家或许已经关注到,我们第二代 Grace 平台量产进展十分顺利,”黄仁勋说,“可以说,我们现在制造超级计算机就像生产口香糖一样。”

黄仁勋还带来了一份特别礼物,NVIDIA DGX Spark AI 超级计算机,这是迄今为止全球最小的超级计算机。

黄仁勋说:“这就是 DGX Spark。你们当中有十位幸运儿将赢得这台设备。这要是放在圣诞树下作为礼物,是不是很酷?”

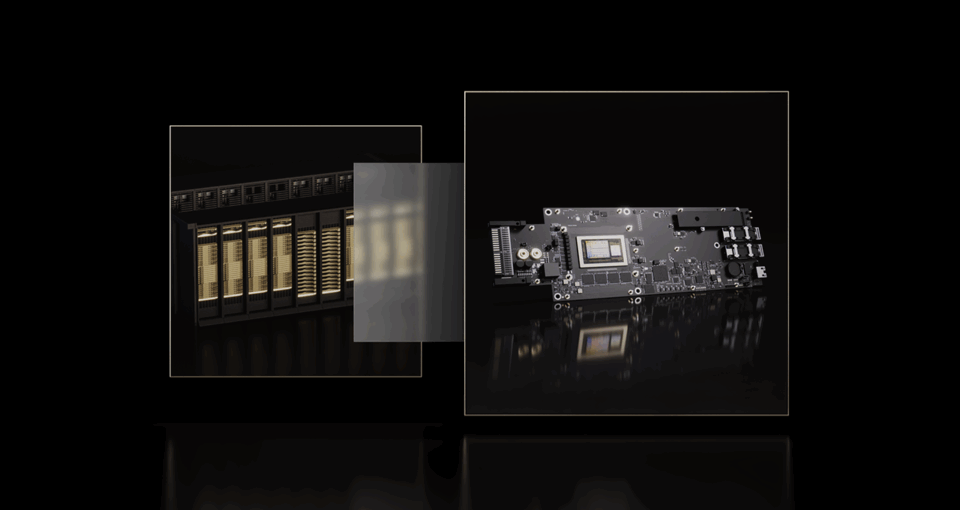

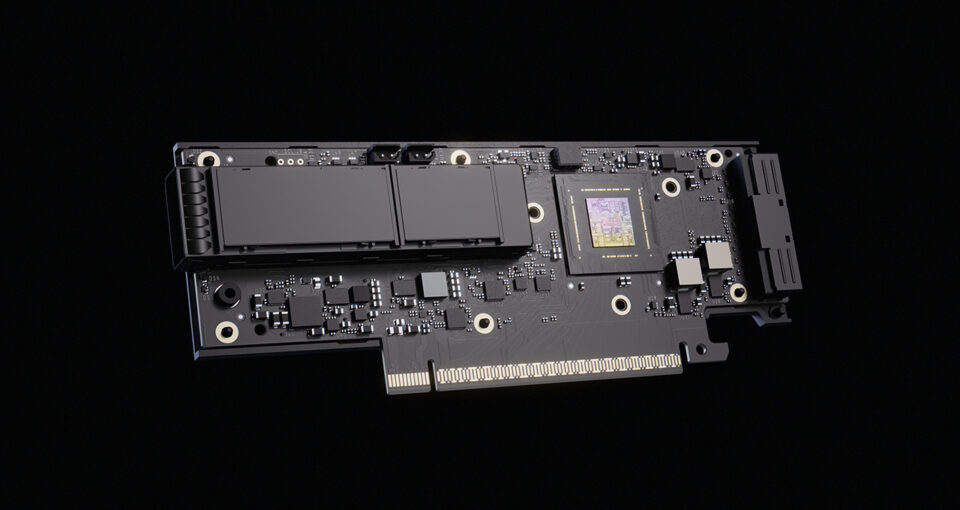

上个月,NVIDIA 开始交付 DGX Spark。这款是迄今为止全球最小的 AI 超级计算机。DGX Spark 将每秒千万亿次的 AI 性能和 128GB 统一内存集成于紧凑的台式机外形中,使开发者能够在多达 2000 亿个参数的模型上运行推理,并在本地对模型进行微调。DGX Spark 基于 Grace Blackwell 架构打造,集成了 NVIDIA GPU、CPU、网络、CUDA 库和完整的 NVIDIA AI 软件堆栈。

DGX Spark 的统一内存和 NVIDIA NVLink-C2C 互连提供了是 PCIe Gen5 的 5 倍带宽,可实现更快的 GPU-CPU 数据交换。这提高了大型模型的训练效率,降低了延迟,并支持无缝微调工作流程,所有这些都在桌面外形规格内完成。

最新的 AI 物理开放模型系列 NVIDIA Apollo 正式发布

NVIDIA 在 SC25 上还推出了面向 AI 物理的开放模型系列 NVIDIA Apollo。Applied Materials、Cadence、LAM Research、Luminary Cloud、KLA、PhysicsX、Rescale、西门子和 Synopsys 等行业领先企业正采用这些开放模型来模拟和加速电子设备自动化和半导体、计算流体动力学、结构力学、电磁学、气象等多个领域的设计流程。

该开放模型系列利用 AI 物理领域的最新成果,将神经运算符、Transformer 和扩散技术等领先的机器学习架构,与特定领域的知识相结合。Apollo 将提供用于训练、推理和基准测试的预训练检查点和参考工作流,使开发者根据其特定需求集成和自定义模型。

NVIDIA Warp 助力物理模拟 🔗

NVIDIA Warp 是一个专门构建的开源 Python 框架,可将计算物理和 AI 的 GPU 加速提升高达 245 倍。

NVIDIA Warp 为仿真、机器人和机器学习工作负载提供了一种结构化方法,它结合了 Python 的易用性以及与原生 CUDA 代码相当的性能。

Warp 支持创建 GPU 加速的 3D 仿真工作流,这些工作流可与 PyTorch、JAX、NVIDIA PhysicsNeMo 和 NVIDIA Omniverse 中的机器学习(ML)工作流集成。这使开发者无需离开 Python 编程环境,即可运行复杂的仿真任务并大规模生成数据。

通过提供 CUDA 级性能和 Python 级生产力,Warp 简化了高性能仿真工作流的开发。它旨在通过降低 GPU 编程的门槛来加速 AI 研究和工程,使高级仿真和数据生成更高效、更易于使用。

西门子、Neural Concept、Luminary Cloud 等公司正在采用 NVIDIA Warp。

展示为 AI 工厂操作系统赋能 NVIDIA BlueField-4 🔗

在 GTC 华盛顿特区上亮相的 NVIDIA BlueField-4 DPU 正在为 AI 工厂操作系统赋能。通过卸载、加速和隔离网络、存储和安全等关键的数据中心功能,NVIDIA BlueField-4 DPU 可以释放 CPU 和 GPU,使其完全专注于计算密集型工作负载。

NVIDIA BlueField-4 集成了 64 核 NVIDIA Grace CPU 和 NVIDIA ConnectX-9,大幅提升了性能效率和零信任安全性。它支持多租户环境、快速数据访问和实时保护,并通过原生集成的 NVIDIA DOCA 微服务实现可扩展的容器化 AI 操作。这些技术共同推动数据中心向智能的、软件定义引擎转型,助力构建万亿级及更高级别 Token (词元) 的 AI 应用。

随着 AI 工厂和超级计算中心的规模和功能不断扩展,需要更快、更智能的存储基础设施来管理结构化、非结构化和 AI 原生数据,以进行大规模训练和推理。

领先的存储创新企业 (DDN、VAST Data 和 WEKA) 正在采用 BlueField-4 来重新定义 AI 和科学工作负载的性能和效率。

- DDN 正在构建新一代 AI 工厂,加速数据流水线,以更大限度地提高处理 AI 和 HPC 工作负载的 GPU 利用率。

- VAST Data 正在通过跨大规模 AI 集群的智能数据传输和实时效率来推进 AI 流水线。

- WEKA 正在 BlueField-4 上推出 NeuralMesh 架构,可直接在 DPU 上运行存储服务,以简化和加速 AI 基础设施。

这些高性能计算存储领域的领先企业共同展示了 NVIDIA BlueField-4 如何改变数据传输和管理,将存储转变为下一代超级计算和 AI 基础设施的性能加速器。

NVIDIA CPO (光电一体化封装) 技术,提高速度和可靠性 🔗

TACC、Lambda 和 CoreWeave 宣布将于明年初在新一代系统中采用 NVIDIA Quantum-X Photonics CPO 交换机。

NVIDIA Quantum-X Photonics 网络交换机能够大幅降低 AI 工厂和超级计算中心的能耗和运营成本。NVIDIA 已经实现了融合电路和光通信一体的大规模部署。

随着 AI 工厂发展到前所未有的规模,网络必须与时俱进。通过取消传统插拔式光模块这一导致工作运行故障的常见原因,NVIDIA Photonics 交换机系统不仅将能效提高了 3.5 倍,而且可靠性提高了 10 倍,使应用能够在不中断的情况下运行时间延长 5 倍。

在硅谷举办的 GTC 2024 上,NVIDIA 推出了 NVIDIA Quantum-X800 InfiniBand 交换机,专为支持万亿级参数的生成式 AI 模型而打造。得益于 SHARPv4 和 FP8 等创新技术,这些平台可提供惊人的 800Gb/s 端到端吞吐量,其带宽是上一代产品的 2 倍,网络计算能力是前代产品的 9 倍。

随着 NVIDIA Quantum-X800 在大规模 AI 场景下的广泛采用,今年早些时候在 GTC 上宣布推出的 NVIDIA Quantum-X Photonics 解决了更大规模部署中面临的关键功率、可靠性和信号完整性的挑战。通过将光引擎直接集成到交换机上,它可以消除插拔式光模块带来的故障和链路闪断等问题,使工作负载能够不间断地大规模运行,并确保基础设施能够支持新一代计算密集型应用,可靠性相比插拔式光模块高 5 倍。

Lambda 云基础设施产品经理 Maxx Garrison 表示:“NVIDIA Quantum-X Photonics 代表了构建高性能、高可靠 AI 网络的趋势。这些在能效、信号完整性和可靠性方面的进步将成为支撑客户高效、大规模工作负载的关键。”

SHARPv4 支持网络内聚合和归约,大幅减少了 GPU 到 GPU 的通信。SHARPv4 与 FP8 精度相结合,可以降低对通信带宽和计算的需求,加速万亿级参数模型的训练,实现更快的收敛和更高的吞吐量,是 NVIDIA Quantum-X800 和 Quantum-X Photonics 交换机的标配。

CoreWeave 联合创始人兼首席技术官 Peter Salanki 表示:“CoreWeave 正在构建面向 AI 的 Essential Cloud。借助 NVIDIA Quantum-X Photonics,可以提高能效,并进一步增强 CoreWeave 在支持大规模 AI 工作负载方面广受认可的高可靠性,来帮助我们的客户充分发挥下一代 AI 的潜力。”

NVIDIA Quantum-X Photonics 平台包括 NVIDIA Quantum Q3450 CPO InfiniBand 交换机和 ConnectX-8 SuperNIC,专为需要显著降低功耗、提高可靠性和降低延迟的高性能环境而设计。

全球超级计算中心采用 NVQLink

全球十余个顶尖科学计算中心正在采用 NVQLink,这是一种连接加速计算和量子处理器的通用互连技术。

NVIDIA 加速计算业务副总裁兼总经理 Ian Buck 表示:“在 SC 上,我们宣布正在与全球各地的超级计算中心合作。这些中心致力于构建新一代量子 GPU、CPU GPU 超级计算机,以及如何将它们连接到其特定研究领域或量子计算部署平台。”

NVQLink 可将量子处理器与 NVIDIA GPU 相连接,从而实现由 CUDA-Q 软件平台提供支持的大规模工作流。NVQLink 的开放式架构为全球超级计算中心整合各类量子处理器提供了关键纽带,同时在 FP4 精度下提供 40 PetaFLOPS 的 AI 性能。

未来,每台超级计算机都将利用量子处理器来扩展其可以解决的问题范围,并且每台量子处理器都将依赖于 GPU 超级计算机来实现正常运行。

量子计算公司 Quantinuum 推出的新型 Helios QPU 已通过 NVQLink 与 NVIDIA GPU 集成,实现了全球首个可扩展 qLDPC 量子纠错码的实时解码。得益于 NVQLink 微秒级的低延迟,该系统保持了 99% 的保真度,而在未进行校正的情况下,该系统保持了 95% 的保真度。

借助 NVQLink,科学家和开发者在量子硬件和经典硬件之间架起了通用桥梁,使可扩展的纠错、混合应用和实时量子 GPU 工作流变得切实可行。

NVQLink 已被亚太地区、欧洲和中东地区以及美国的众多研究中心、超级计算中心和实验室采用。

开发现实世界的混合应用

采用 NVQLink 的 Quantinuum Helios QPU 提供:

- 使用 NVQLink 校正时,保真度约为 99%,而不使用 NVQLink 校正时,保真度约为 95%

NVQLink 将量子处理器与 GPU 超级计算相结合,实现可扩展的纠错和混合应用。科学家可以通过 CUDA-Q API 获得统一的编程环境。开发者可以实时构建和测试量子 – GPU 工作流。

借助 NVQLink,全球超级计算中心正在为实用的量子经典系统奠定基础,以前所未有的速度和规模将不同的量子处理器与 NVIDIA 加速计算单元相连接。

NVIDIA 和 RIKEN 推动科学前沿发展

NVIDIA 和 RIKEN 正在构建两台新的 GPU 加速超级计算机扩大当地在科学和量子计算 AI 领域的领导地位。

- 用于 AI for Science 的 系统:1600 块 Blackwell GPU 将为生命科学、材料科学、气候和天气预报、制造和实验室自动化领域的研究提供支持。

- 量子计算系统:540 块 Blackwell GPU 将加速量子算法、混合模拟和量子经典方法。

在 RIKEN 与 Fujitsu 和 NVIDIA 的合作基础上,还将共同设计 Fugaku 超级计算机的后续产品 FugakuNEXT。预计到 2030 年,FugakuNEXT 将把应用性能提高 100 倍,并集成生产级的量子计算机。

这两个新的 RIKEN 系统预计将于 2026 年春季投入使用。

Arm 采用 NVIDIA NVLink Fusion

AI 正在重塑数据中心,每瓦效率成为衡量成功的关键。核心驱动力是 Arm Neoverse,其部署核心数已超过 10 亿。预计到 2025 年在超大规模市场的份额将达到 50%。AWS、Google、微软、Oracle 和 Meta 在内的各大提供商都基于 Neoverse 构建,这凸显了 Neoverse 在支持大规模 AI 方面的作用。

为了满足激增的需求,Arm 正在通过 NVIDIA NVLink Fusion 扩展 Neoverse,这是 Grace Blackwell 率先推出的高带宽、一致性互连技术。NVLink Fusion 将 CPU、GPU 和加速器连接到一个统一的机架级架构中,消除了限制 AI 性能的内存和带宽瓶颈。借助 Arm 的 AMBA CHI C2C 协议连接,可确保基于 Arm 的 CPU 与合作伙伴首选加速器之间实现无缝数据传输。

Arm 和 NVIDIA 共同为 AI 基础设施设定了新标准,使生态系统合作伙伴能够构建差异化、高能效的系统,加速整个 AI 时代的创新。

Buck 表示:“无论是构建自己的 ARM CPU 还是使用 ARM IP,都可以访问 NVLink Fusion,将 ARM CPU 与 NVIDIA GPU 或 NVLink 生态系统的其他部分连接,这一切都发生在机架和纵向扩展的基础设施上。”

为加速计算提供更智能的动力

随着 AI 工厂规模的扩大,能源成为新的瓶颈。NVIDIA Domain Power Service (DPS) 将这一限制转化为机会,将电力转化为一种动态、可协调的资源。DPS 作为 Kubernetes 服务运行,能够对从机架到房间再到设施的整个数据中心的能源使用情况进行建模和管理。它使运营商能够通过智能地限制电力来提高每兆瓦的性能,在不扩展基础设施的情况下提高吞吐量。

DPS 与用于设计和运营新一代数据中心的平台 NVIDIA Omniverse DSX Blueprint 紧密集成。它与 Power Reservation Steering 等技术配合使用,以平衡整个设施的工作负载,并与 Workload Power Profile 解决方案配合使用,以根据特定工作的需求调整 GPU 的功率。它们共同构成了 DSX Boost,一个能源感知控制层,可在实现性能目标的同时更大限度地提高效率。

DPS 还延伸到数据中心之外。借助面向电网的 API,它支持自动减负和需求响应,帮助公共事业公司在用电高峰事件期间稳定电网。最终打造出一个具有弹性的电网交互式 AI 工厂,将每一瓦电力都转化为可衡量的进程。

NVIDIA 与 CoreWeave 获得 Graph500 BFS 基准测试冠军,性能较此前纪录提升翻倍

NVIDIA 在第 30 期 Graph500 宽度优先搜索 (BFS) 榜单中获得第一名,使用部署在 CoreWeave 达拉斯数据中心的 8,192 块 NVIDIA Hopper GPU,取得了每秒遍历 410 万亿条边 (TEPS) 的成绩,性能较此前最优纪录提升超两倍。

该基准测试用于衡量系统处理超大规模图数据集的能力。在此次测试中,NVIDIA 使用了包含 2.2 万亿个顶点和 35 万亿条边的图数据。

这一成绩得益于 NVIDIA Hopper GPU 架构、NVIDIA Quantum-2 InfiniBand 网络、NVIDIA 与 CoreWeave 的协作,以及基于众多 NVIDIA 技术构建的定制化软件实现。其中包括 CUDA 平台、NVSHMEM 并行编程接口、InfiniBand GPUDirect Async 技术,以及专为高性能 GPU 间主动消息传递构建的库。