生成式 AI,以 ChatGPT 等大型语言模型(LLM)应用、Stable Diffusion 和 Adobe Firefly 等图片生成器,以及 NVIDIA DLSS 3 Frame Generation(DLSS 3 帧生成技术)等游戏渲染技术为代表,正在迅速为生产力、内容创作、游戏等开创计算的新时代。

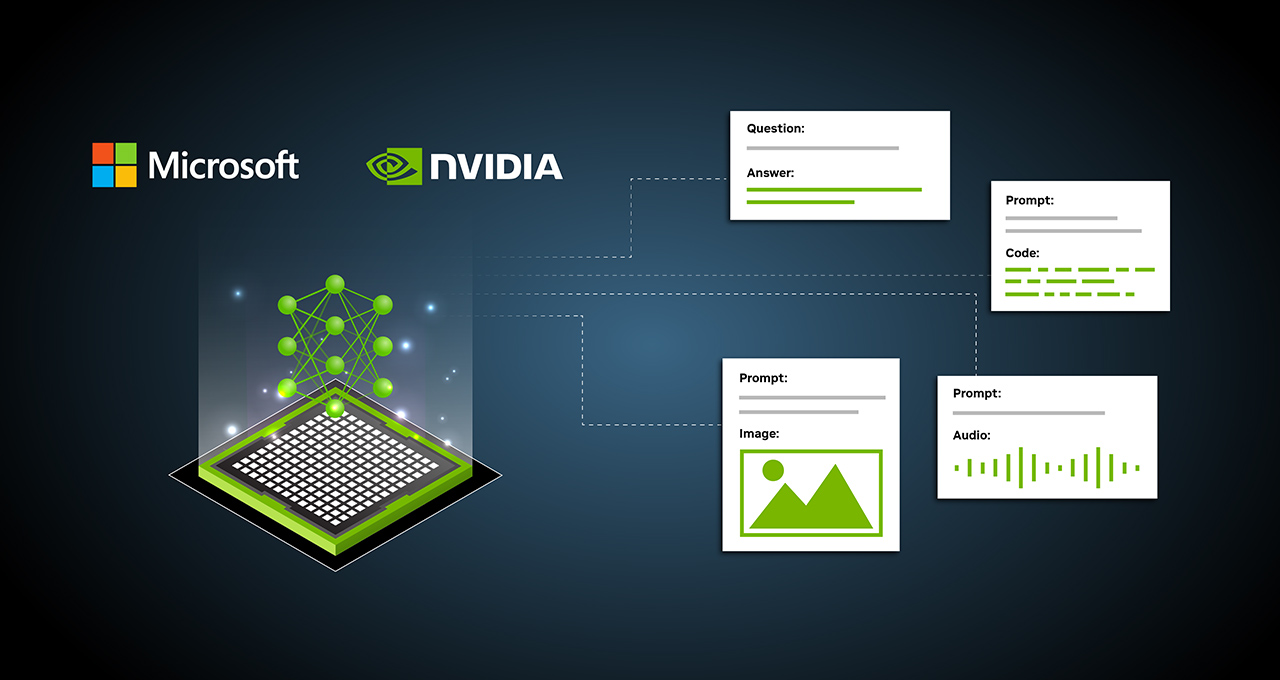

在微软Build 开发者大会上,NVIDIA 和微软展示了一系列搭载 NVIDIA RTX GPU 的 Windows 11 PC 和工作站的先进技术,旨在满足生成式 AI 的需求。

超过 400 款应用和游戏已采用 AI 技术,通过 RTX GPU 上的专用处理器 Tensor Core 进行加速。今天发布的内容,包括用于在 Windows PC 上开发 AI 的工具、优化和部署 AI 的框架,以及驱动性能和能效提升,将使开发人员能够以生成式 AI 为核心来构建下一代 Windows 应用。

微软 Windows 芯片和系统集成副总裁 Pavan Davuluri 表示:“ 未来几年,AI 将成为 Windows 用户创新的最大驱动力。通过与 NVIDIA 在硬件和软件优化方面进行合作,我们为开发人员提供了一种革命性、高性能并易于部署的体验。”

利用 Linux 的 Windows 子系统开发模型

AI 开发通常是在 Linux 上进行的,需要开发人员启动双系统, 或是使用多台 PC 在 AI 开发操作系统中进行工作,同时仍然可以获得 Windows 生态系统的深度和广度。

过去的几年里,微软一直致力于让 Linux 直接在 Windows 操作系统中运行,也就是适用于 Linux 的 Windows 子系统(WSL)。NVIDIA 一直与微软密切合作,为 WSL 内部的整个 NVIDIA AI 软件堆栈提供 GPU 加速和支持。开发人员现在可以使用 Windows PC 来满足所有本地 AI 开发需求,并支持 GPU 加速的 WSL 深度学习框架。

NVIDIA RTX GPU 在台式机工作站中提供高达 48GB 的显存,开发人员现在可以在 Windows 上处理以前只能在服务器上处理的模型。大显存还提高了 AI 模型本地微调的性能和质量,使设计师能够根据自己的风格或内容进行定制。NVIDIA 数据中心 GPU 也运行相同的 NVIDIA AI 软件堆栈,开发人员因此可以轻松将模型推送到微软 Azure 云上进行大规模训练。

快速优化并部署模型

有了经过训练的模型,开发人员需要针对目标设备来优化和部署 AI。

微软发布了 Microsoft Olive 工具链,用于优化 PyTorch 模型并将其转换到 ONNX,使开发人员能够自动利用 RTX Tensor Core 等 GPU 硬件加速。开发人员可以通过 Olive 和 ONNX 优化模型,并将 Tensor Core 加速的模型部署到 PC 或云端。微软将继续投资,使 PyTorch 及相关工具和框架与 WSL 无缝协作,从而提供最佳的 AI 模型开发体验。

提升 AI 的性能和能效

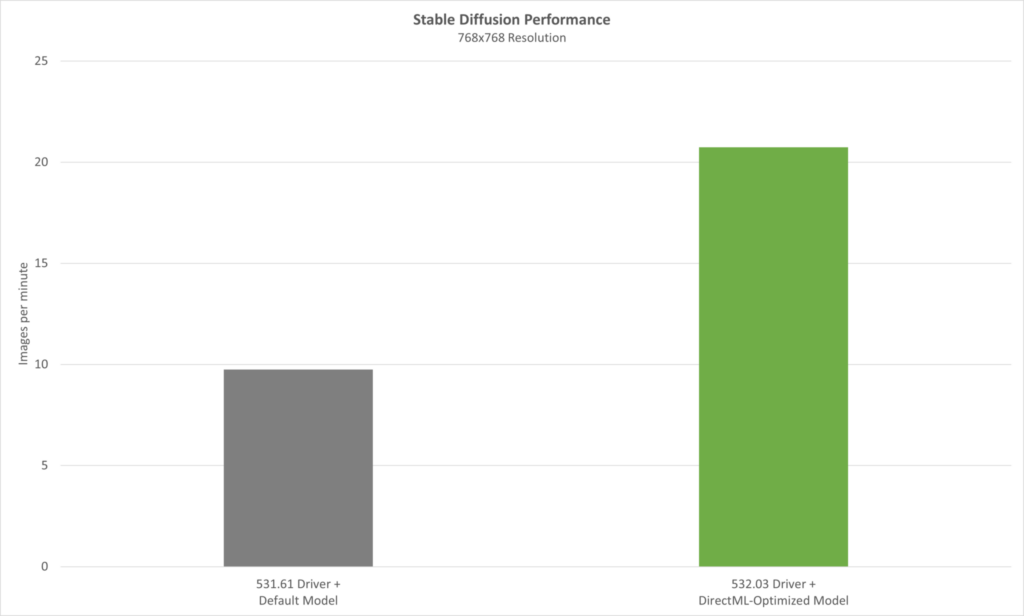

一旦部署,生成式 AI 模型需要令人难以置信的推理性能。RTX Tensor Core 为 AI 推理提供高达 1,400 的 Tensor TFLOPS(万亿次浮点运算)。过去一年,NVIDIA 一直致力于提升 DirectML 的性能,以便充分利用 RTX 硬件的优势。

5 月 24 日,我们将在 532.03 版驱动中发布最新的优化,与 Olive 优化的模型相结合,大幅提升 AI 性能。使用 Olive 优化版 Stable Diffusion 文本-图像转换器以及受欢迎的 Automatic1111 发行版,新驱动程序的性能提高了 2 倍以上。

随着 AI 即将进入几乎所有 Windows 应用,提供节能的推理性能变得至关重要——尤其对于笔记本电脑来说。NVIDIA 即将推出新的 Max-Q 低功耗推理,用于 RTX GPU 上的纯 AI 工作负载。它在优化 Tensor Core 性能的同时尽可能地降低 GPU 的功耗,延长电池续航时间,并使系统保持出色的散热和降噪表现。根据负载需要,GPU 可以动态地扩展,以提供最高的 AI 性能。

现在就加入 PC 的 AI 变革

顶级软件开发商,如 Adobe、DxO、ON1 和 Topaz,已经将 NVIDIA AI 技术与 400 多款被 RTX Tensor Core 优化的 Windows 应用和游戏结合起来。

“AI、机器学习和深度学习已经用于所有 Adobe 应用,并推动创意的未来发展。我们与 NVIDIA 合作,不断优化 AI 模型的性能,在 RTX GPU 上为 Windows 用户提供尽可能最佳的体验。” ——Adobe 数字媒体首席技术官 Ely Greenfield

“NVIDIA 正帮助我们在 RTX GPU 上优化 WinML 模型的性能,这将加速 DxO DeepPRIME 中的 AI,并更快更好地去噪、去马赛克。” ——DxO 高级工程副总裁 Renaud Capolunghi

“与 NVIDIA 和微软合作,在 RTX GPU 上加速我们在 Windows 中运行的 AI 模型,这让用户受益匪浅。我们已经看到 AI 照片编辑软件套件的性能提升了 1.5 倍。” ——ON1 产品副总裁 Dan Harlacher

“我们与 NVIDIA 的广泛合作改进了照片和视频编辑应用套件。借助 RTX GPU,AI 性能得到了大幅提升,增强了用户在 Windows PC 上的体验。” ——Topaz Labs AI 引擎开发负责人 Suraj Raghuraman

NVIDIA 和微软正在为开发人员提供一些资源,以便在 Windows PC 上测试主要的生成式 AI 模型。Hugging Face 上提供了一个 Olive 优化版的 Dolly 2.0 大语言模型。此外,用于对话式 AI 的 NVIDIA NeMo 大型语言模型的 PC 优化版也即将在 Hugging Face 上线。

开发人员还可以通过 NVIDIA 开发者网站上的 AI 加速应用页面,学习如何端到端地优化应用程序以充分利用 GPU 加速。

通过微软 Windows 平台和 NVIDIA 动态 AI 硬件和软件堆栈背后的互补技术,开发人员将能够在 Windows 11 上快速、轻松地开发并部署生成式 AI。

微软 Build 开发者大会将一直持续到 5 月 25 日(星期四)。敬请关注,了解更多关于 AI 塑造未来工作的信息。