NVIDIA 正在与全球各地的企业合作构建 AI 工厂,以采用最新的训练和推理技术,来加速训练和部署新一代 AI 应用。

NVIDIA Blackwell 架构专为满足这些新应用更高的性能要求而打造。在最新一轮 MLPerf Training 基准测试(自 2018 年该基准测试推出以来的第 12 轮)中,NVIDIA AI 平台在每一个基准测试中都实现了大规模的最高性能。而且,在该基准测试最严苛的大语言模型专项测试(Llama 3.1 405B 预训练)中,所有提交结果的测试均采用了 NVIDIA AI 平台。

NVIDIA 平台是唯一一个在 MLPerf Training v5.0 所有基准测试上都提交了测试结果的平台,这突显了其在大语言模型、推荐系统、多模态大语言模型、目标检测和图神经网络等广泛 AI 工作负载上的卓越性能和多功能性。

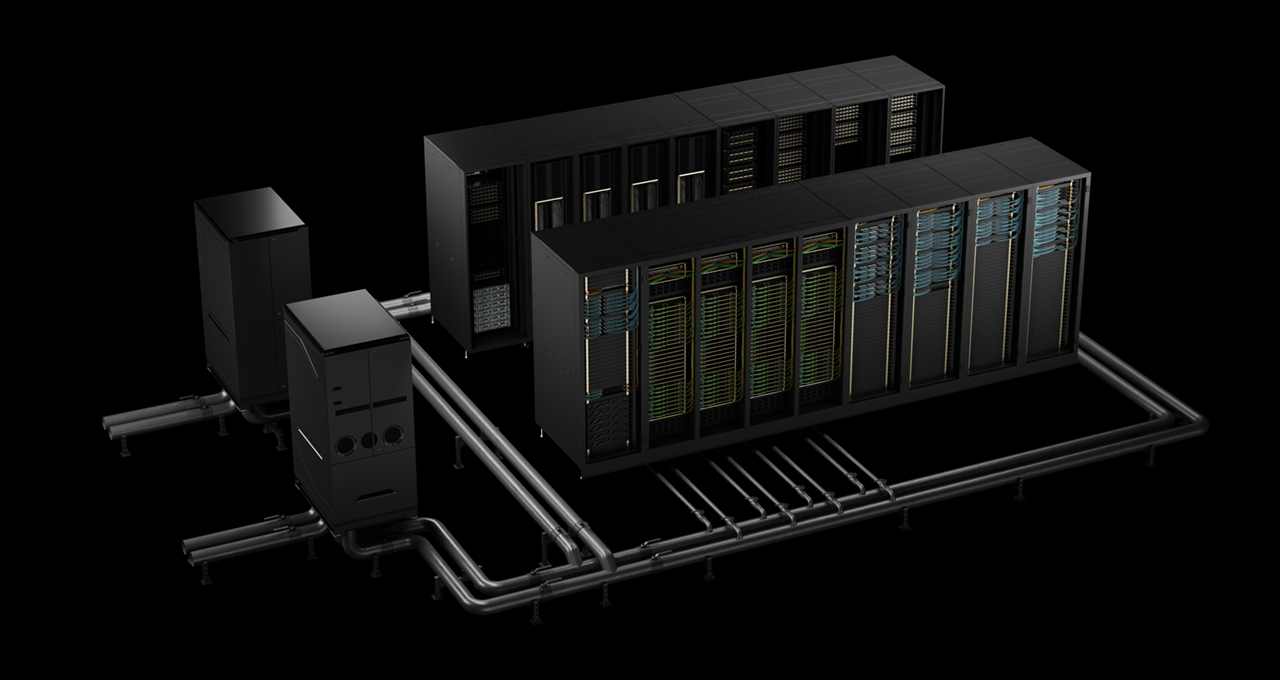

此次大规模测试使用了两台由 NVIDIA Blackwell 平台驱动的 AI 超级计算机,分别是基于 NVIDIA GB200 NVL72 机架级系统的 Tyche 以及基于 NVIDIA DGX B200 系统的 Nyx。此外,NVIDIA 还与 CoreWeave 和 IBM 合作,提交了 GB200 NVL72 的测试结果,该测试使用了总计 2496 个 Blackwell GPU 和 1248 个 NVIDIA Grace CPU。

在新的 Llama 3.1 405B 预训练基准测试中,Blackwell 在相同规模下的性能较上一代架构提升了 2.2 倍。

在 Llama 2 70B LoRA 微调基准测试中,相比上一轮使用相同数量 GPU 的测试结果,配备八个 Blackwell GPU 的 NVIDIA DGX B200 系统实现了 2.5 倍的性能提升。

这些性能跃升凸显了 Blackwell 架构的多项进步,包括高密度液冷机柜、单机柜 13.4TB 的一致性内存、用于纵向扩展的第五代 NVIDIA NVLink 和 NVIDIA NVLink Switch 互连技术,以及用于横向扩展的 NVIDIA Quantum-2 InfiniBand 网络技术。此外,NVIDIA NeMo Framework 软件栈中的创新为新一代多模态大语言模型的训练设定了更高的标准,这对于将代理式 AI 应用推向市场至关重要。

这些由代理式 AI 驱动的应用未来会在 AI 工厂中运行,而 AI 工厂正是代理式 AI 经济的引擎。这些新应用将生成可应用于几乎所有行业和学术领域的 token 和有价值的智能。

NVIDIA 数据中心平台包括 GPU、CPU、高速互连和网络,以及 NVIDIA CUDA-X 库、NeMo Framework、NVIDIA TensorRT-LLM 和 NVIDIA Dynamo 等大量软件。这套高度优化的软硬件技术组合帮助各组织能够更快地训练和部署模型,从而显著缩短价值实现时间。

NVIDIA 合作伙伴生态系统广泛地参与了本轮 MLPerf 测试。除了与 CoreWeave 和 IBM 共同提交测试结果之外,华硕、思科、Dell Technologies、技嘉科技、Google Cloud、HPE、Lambda、联想、Nebius、Oracle Cloud Infrastructure、云达科技和 Supermicro 等厂商也提交了引人关注的测试结果。

了解更多关于 MLPerf 基准测试的信息。