NVIDIA 在本周 COMPUTEX 上重点展示了其全新的 Grace CPU C1,并获得多家主要原始设计制造商合作伙伴的大力支持。

不断扩展的 NVIDIA Grace CPU 产品线,包括功能强大的 NVIDIA Grace Hopper 超级芯片和旗舰版 Grace Blackwell 平台,正在为应对高要求 AI 工作负载的大型企业带来显著的效率与性能提升。

随着 AI 不断快速发展,在为从大语言模型到复杂仿真等应用设计数据中心时,能效已成为一个关键因素。

NVIDIA Grace 架构正帮助直接应对这一挑战。

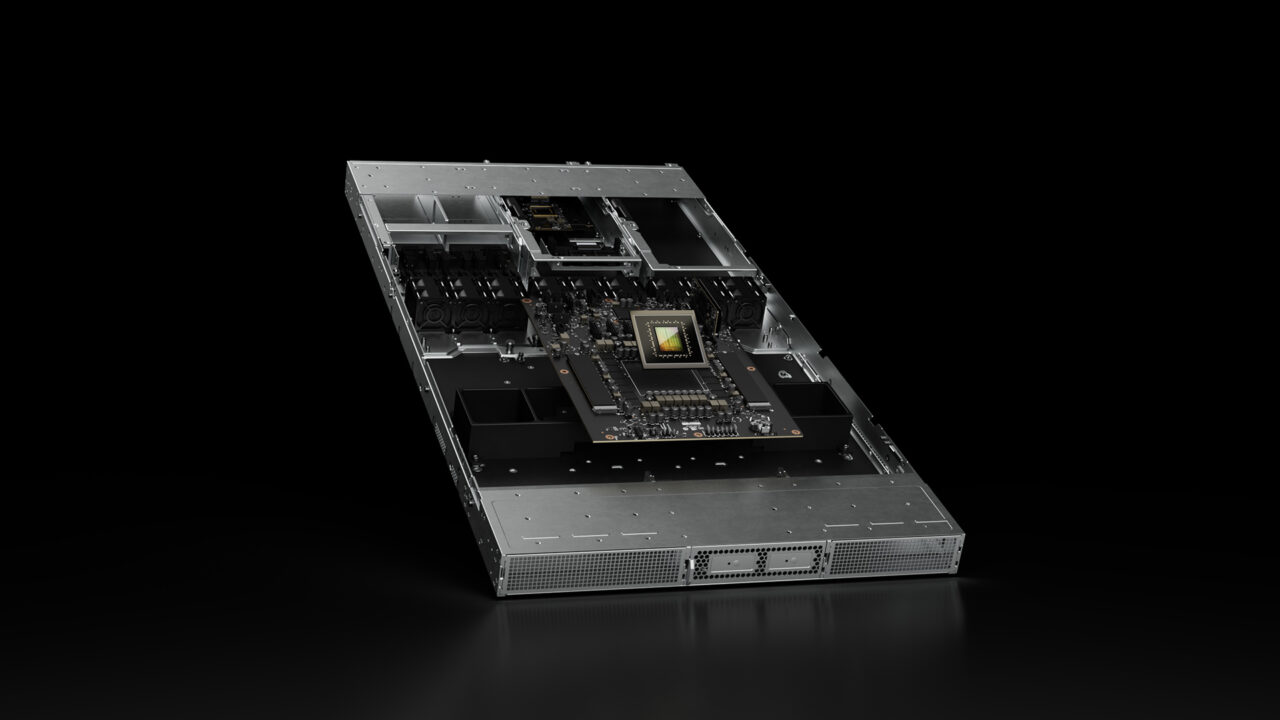

集成了 36 个 NVIDIA Grace CPU 和 72 个 NVIDIA Blackwell GPU 的 NVIDIA Grace Blackwell 机架级系统,正被大型云提供商应用于加速 AI 训练和推理,包括复杂推理和物理 AI 任务。

NVIDIA Grace 架构现在有两种主要配置:双 CPU Grace 超级芯片和全新的单 CPU Grace CPU C1。

C1 版本正在边缘、电信、存储和云部署中获得大量关注,在这类部署中,最大化提高性能功耗比至关重要。

据介绍,与传统 CPU 相比,Grace CPU C1 实现了 2 倍的能效提升,在分布式环境和功耗受限的环境中,这是一项至关重要的优势。

Foxcon、Jabil、Lanner、MiTAC Computing、Supermicro 和 Quanta Cloud Technology 等领先制造商都在推动这一趋势,利用 Grace CPU C1 的功能来开发系统。

在电信领域,NVIDIA Compact Aerial RAN Computer 将 Grace CPU C1 与 NVIDIA Ada Lovelace GPU 和 NVIDIA ConnectX-7 相结合,作为分布式 AI-RAN 平台正日益受到关注,其可满足蜂窝基站部署的功耗、性能和尺寸要求。

NVIDIA Grace 还在存储解决方案中找到用武之地,WEKA 和 Supermicro 正部署该系统,以提高性能和内存带宽。

对现实世界的影响

NVIDIA Grace 的优势不仅限于理论方面,在现实世界部署中,也具有明显优势:

- 埃克森美孚正使用 Grace Hopper 进行地震成像,通过处理大规模数据集以获得次表层特征和地质构造方面的洞察。

- Meta 正在部署 Grace Hopper 用于广告投放与过滤,通过使用 CPU 与 GPU 之间高带宽的NVIDIA NVLink-C2C 互联技术,实现对海量推荐数据表的高效管理。

- 德克萨斯高级计算中心等高性能计算中心正在其 AI 和仿真系统中使用 Grace CPU,以推动研究进展。

NVIDIA GTC 台北大会将于 5 月 21 日至 22 日在 COMPUTEX 期间举行,请通过该会议了解更多有关 AI 的最新进展。