Microsoft Teams 通过 AI 生成的实时字幕和转录帮助世界各地的学生和专业人士参加在线会议。这些功能通过用于训练的 NVIDIA AI 计算技术和用于语音识别模型推理的 NVIDIA Triton 推理服务器获得性能提升。

Teams 为全球近 2.5 亿每月活跃用户提供沟通和协作。Teams 对话使用 Microsoft Azure 认知服务以 28 种语言提供字幕和转录,这一过程很快将在 NVIDIA GPU 上运行关键的计算密集型神经网络推理。

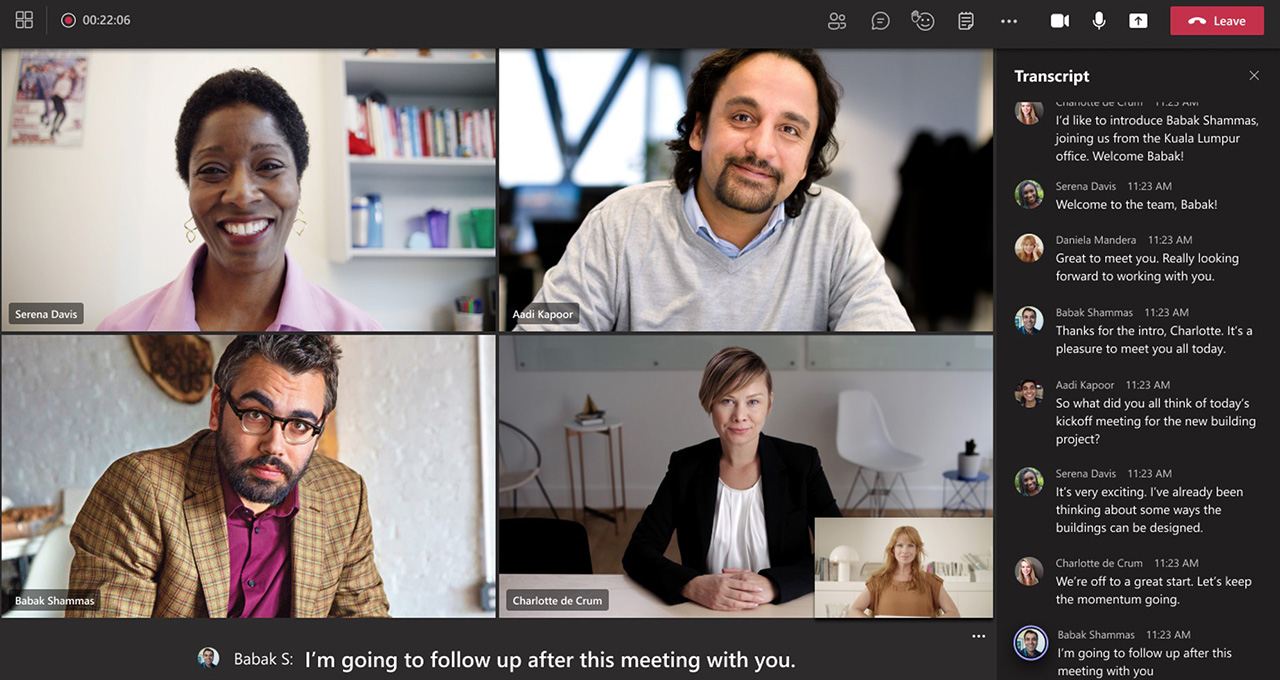

实时字幕功能可帮助与会者实时关注对话,而转录功能可为与会者提供一种简单的方法,以便以后重温好的想法或追看错过的会议。

对于失聪或听力困难的与会者,或者不以会议所用语言为母语的与会者来说,实时字幕功能尤其有用。

Teams 使用认知服务来优化使用 NVIDIA Triton 开源推理服务器软件的语音识别模型。

Triton 助力认知服务支持高度先进的语言模型,以极低的延迟实时提供高度准确、个性化的语音到文本结果。采用 Triton 可确保运行这些语音到文本模型的 NVIDIA GPU 充分发挥其潜力,使用更少的计算资源为客户提供更高的吞吐量,进而降低成本。

底层语音识别技术可用作认知服务中的 API。开发者可以将其用于自定义和运行自有应用程序,用于客户服务呼叫转录、智能家居控制或急救人员的 AI 助手。

AI 贯穿于每一个字

Teams 的转录和字幕由认知服务生成,将语音转换为文本,并识别每个语句的讲话者。该模型可识别行话、名称和其他会议上下文,提高了字幕的准确性。

微软的 Teams 呼叫、会议和设备的首席产品经理 Shalendra Chhabra 说:“此类 AI 模型非常复杂,需要数千万个神经网络参数才能在数十种不同的语言中提供准确的结果。但模型越大,实时运行就越难以经济高效。”

使用 NVIDIA GPU 和 Triton 软件可帮助微软在不牺牲低延迟的情况下,通过强大的神经网络实现高准确性:语音到文本的转换仍然为实时串流。

启用转录功能后,个人可以在会议结束后轻松追看错过的材料。

Triton 功能的 Trifecta 提高了效率

NVIDIA Triton 帮助简化 AI 模型部署并解锁高性能推理。用户甚至可以针对其应用程序开发定制后端。利用该软件的一些关键功能,Microsoft Teams 的字幕和转录功能扩展到更多的会议和用户,包括:

- 串流推理:NVIDIA 和 Azure 认知服务合作,使用一种新颖的有状态串流推理功能定制语音到文本应用程序,该功能可以跟踪先前语音上下文,以改进延迟敏感的字幕准确性。

- 动态批处理:批量大小是神经网络同时处理的输入样本的数量。在 Triton 中进行动态批处理时,单个推理请求会自动组合成批量,更好地利用 GPU 资源而不影响模型延迟。

- 并发模型执行:实时字幕和转录需要同时运行多个深度学习模型。Triton 使开发者能够同时在单个 GPU 上执行此任务,即使使用不同的深度学习框架的模型也能够做到这一点。

通过 Azure 认知服务开始在您的应用程序中使用语音转文本功能,并详细了解 NVIDIA Triton 推理服务器软件如何帮助团队大规模部署 AI 模型。