ComfyUI 是一个开源的、基于节点的图形界面,用于运行和构建生成式 AI 工作流来进行内容创作。该界面在过去一个月发布了重大更新,包括对 NVIDIA RTX GPU 高达 40% 的性能提升,以及对 Wan 2.2、Qwen-Image、FLUX.1 Krea [dev] 和 Hunyuan3D 2.1 等新 AI 模型的支持。

NVIDIA 还发布了专由 TensorRT 优化的热门扩散模型 (比如 Stable Diffusion 3.5 和 FLUX.1 Kontext) 的 NIM 微服务,让用户在 ComfyUI 运行时,模型推理速度最高提升 3 倍,显存占用降低 50%。

此外,一个 NVIDIA RTX Remix (一个让模组制作者重制经典游戏的平台) 更新在今天发布,该更新增加了高级路径追踪粒子系统,可呈现令人惊艳的视觉效果,为经典游戏注入新的活力。

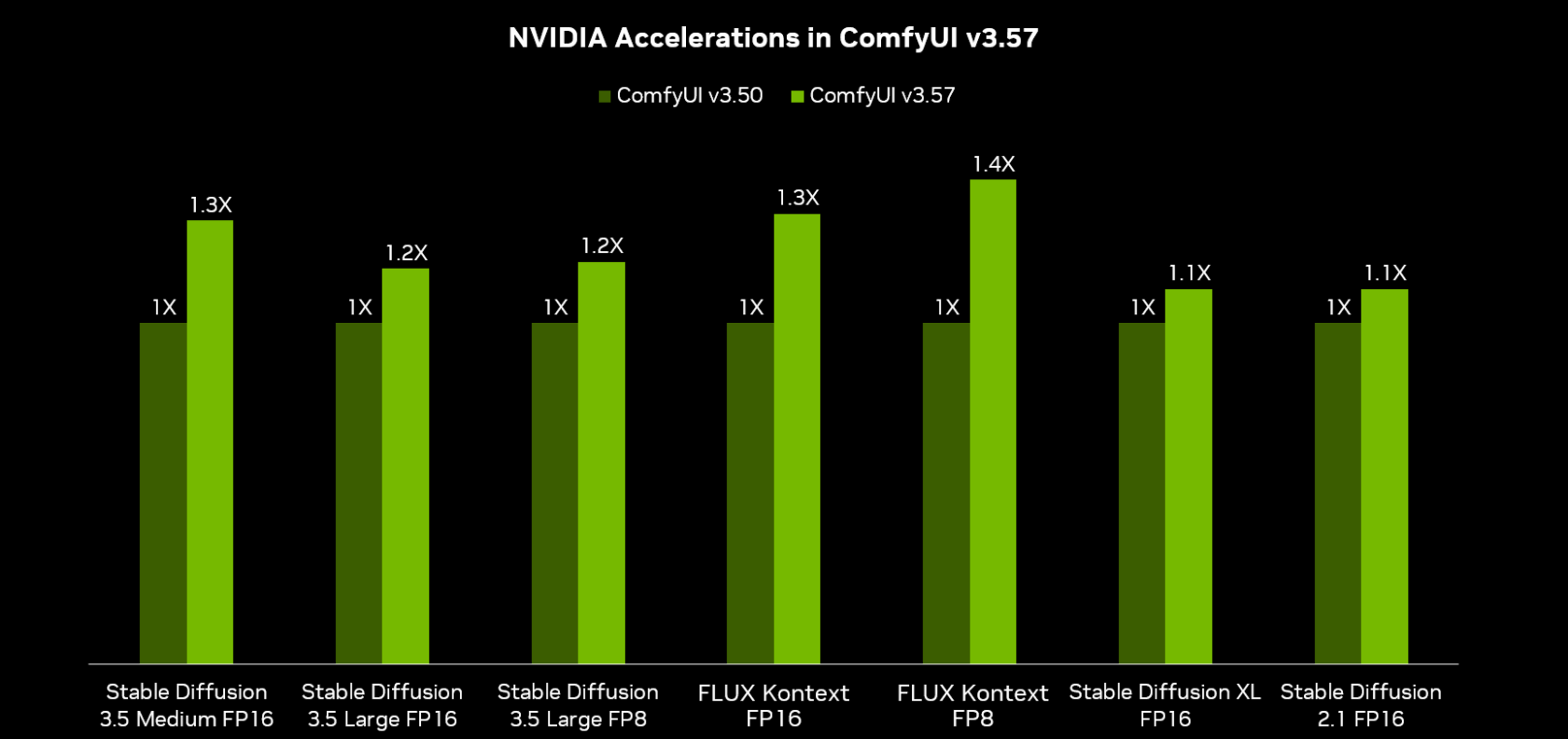

ComfyUI v3.57 借助 RTX 实现性能提升

NVIDIA 与 ComfyUI 合作,将 AI 模型性能提升高达 40%。相比之下,GPU 代际升级通常只能带来 20-30% 的性能提升。

对优化扩散模型在应用中的性能和效率有兴趣的开发者可以访问开发者论坛,进一步了解 NVIDIA 如何帮助加速这些工作流。

最先进的 AI 模型,由 RTX 加速

多款令人惊叹的 AI 内容创作模型在过去几周发布,所有这些模型现在都可以在 ComfyUI 中使用。

Wan 2.2 是一款全新的视频生成模型,在PC上也能实现极致的视频质量和高度可控的视频创作体验。它是来自 Wan AI 的最新模型,Wan AI 是一个创意 AI 平台,提供一系列令人印象深刻的 AI 模型,包括文本生成图像、文本生成视频、图像生成视频和语音生成视频。GeForce RTX 和 NVIDIA RTX PRO GPU 是仅有的能够在 ComfyUI 中运行 Wan 2.2 14B 模型且不会出现严重输出延迟的 GPU。请看以下使用单个提示词生成的例子:“A robot is cracking an egg, but accidentally hits it outside the bowl.”

Qwen-Image 是阿里巴巴新推出的图像生成基础模型,在复杂文本渲染和精确图像编辑方面取得了重大进步。它擅长渲染复杂文本、处理精细编辑以及在生成的图像中保持语义和视觉的准确性。该模型在 GeForce RTX 5090 上的运行速度比在 Apple M3 Ultra 上快 7 倍。

Black Forest Labs 全新的 FLUX.1 Krea [dev] AI 模型是 Krea 1 的开放权重版本,不仅性能强劲,还专门训练以生成更真实、更有多样性的图片,并且解决了以往“AI 风”图片常见的过度饱和问题,让画面更自然、更具美感。Black Forest Labs 称该模型“opinionated”(独具一格),因为它提供了各种各样的视觉上有趣的图像。该模型在 GeForce RTX 5090 上的运行速度比在 Apple M3 Ultra 上快 8 倍。

Hunyuan3D 2.1 是一款完全开源、可投入生产使用的 3D 生成式系统,能够将输入的图像或文本转化为带物理渲染材质的高保真 3D 资产。核心组件包括一个用于几何体生成的 33 亿参数模型和一个用于纹理分析以快速生成更逼真材质的 20 亿参数模型。在 Blackwell RTX GPU 上,运行得更快。

开始使用先进的视觉生成技术

视觉生成式 AI 是一个强大的工具,但即使是技术专家也可能难以入门,而学习使用更先进的技术通常需要数月时间。

ComfyUI 提供了模板或预设节点来完成特定任务,例如在不同的生成中保持角色不变、调整图像光线或加载微调,从而使入门高级工作流变得简单。这也能让没有技术背景的艺术家也能轻松使用高级 AI 工作流。

以下是入门生成式 AI 的 10 个关键技术:

- 通过定义开始帧和结束帧来引导视频生成:上传开始帧和结束帧,以及视频片段的开始和结束方式。Wan 2.2 随后便可生成流畅的动画过渡,填充中间的帧以创建连贯的动画。它非常适合制作动画、场景切换或定义姿态。

- 使用自然语言编辑图像:使用 FLUX.1 [dev] KONTEXT 编辑图像的特定文本部分。

- 提升图像或视频画质:拍摄分辨率较低的图像或视频,通过添加逼真的高频细节来提高分辨率和细节质量。

- 控制局部构图:通过控制图像特定区域内视觉元素的排列和布局,对图像生成进行更精细的控制。

- 重新设计图像:使用 FLUX Redux 创建图像的不同版本,同时保留核心视觉元素和细节。

- 利用图像转多视图转 3D 模型:使用从不同角度对一个对象捕捉的多张图像,创建高保真的纹理化 3D 模型。

- 将声音转换为视频:直接根据语音、音乐或环境声音等音频输入创建视频片段或动画。

- 控制视频轨迹:自动引导视频中对象、相机或场景的运动。

- 使用图像修复功能编辑图像:以视觉上无缝、与周围区域上下文一致的方式填充或更改数字图像中缺失或不需要的部分。

- 通过外绘功能扩展画布:生成新的图像内容以扩展现有图像或视频片段的边界,向裁剪的部分添加细节或补充场景。

扩展 ComfyUI 区域

ComfyUI 插件使用户能够将生成式 AI 工作流添加到其现有应用中。ComfyUI 社区已开始为一些最热门的创意应用构建插件。

Adobe Photoshop 的这款插件,不仅能搭配 Photoshop 自带的 Firefly AI 模型用,还允许用户自由选择特定任务的专用模型并自定义工作流。本地推理还可以实现无限制的低延迟生成式填充。

Blender 插件 (在用于 3D 引导生成式 AI 的 NVIDIA AI Blueprint 中提供) 允许用户连接 2D 和 3D 工作流。艺术家们可以在 ComfyUI 中使用 3D 场景来控制图像生成或创建纹理,并将其应用于单独的 3D 资产。

Foundry Nuke 插件 (与 Blender 类似) 可连接 2D 和 3D 工作流,这样用户无需按 Alt-Tab 即可在应用之间切换。虚幻引擎插件直接在虚幻引擎用户界面中启用 ComfyUI 节点,以便使用生成式扩散模型快速创建和优化场景纹理。请参见下面的示例。

在 ComfyUI 中运行针对 NVIDIA RTX GPU 超优化的模型

使用 NVIDIA RTX GPU 的最佳方式是使用 TensorRT 库,这是一个高性能深度学习推理引擎,旨在最大限度地提高 NVIDIA RTX GPU 中 Tensor 核心的推理速度。

NVIDIA 已与顶级 AI 实验室合作,将 TensorRT 集成到他们的模型中,例如 Black Forest Labs 的模型和 Stability AI 的模型。这些模型还提供了量化版本,即网络的压缩版本,可将显存占用减少 50-70%,推理速度提升高达 2 倍,同时保持相似的质量。

TensorRT 优化的模型可以通过 TensorRT 节点直接在 ComfyUI 中运行,目前支持 SDXL、SD3 和 SD3.5 以及 FLUX.1-dev 和 FLUX.1-schnell 模型。这个节点会把 AI 模型转换成 TensorRT 优化模型,然后根据用户的 GPU 生成专属的 TensorRT 引擎,也就是专门针对硬件高效执行的“线路图”,大幅提升推理速度和效率。

不过,量化模型需要更多的工作。对于有兴趣运行量化和 TensorRT 优化模型的用户,NVIDIA 在称为 NIM 微服务的简单容器中提供了预配置的文件。用户可以在 ComfyUI 中使用 NIM 节点来加载这些容器,并使用 FLUX.1-dev、FLUX.1-schnell、FLUX.1 Kontext、SD3.5 Large 和 Microsoft TRELLIS 等模型的量化版本。

Remix 更新增加了路径追踪粒子系统

今天,一个新的 RTX Remix 更新通过 NVIDIA App 发布,该更新增加了高级粒子系统,使模组制作者能够增强传统的火焰和烟雾效果,以及类似电子游戏“传送门 (Portal)”中的奇幻效果。

在 RTX Remix 中,经典游戏中的传统粒子可以被解释为路径追踪,使它们能够投射逼真的光线,从而增强许多场景的呈现。但这些粒子终究已有 20 多年的历史,缺乏细节、特色和流畅的动画。

RTX Remix 的新粒子具有物理精准的属性,可以与游戏的光照和其他效果交互。这使得粒子能够碰撞、准确地移动以响应风和其他力、在表面上反射、投射阴影和形成自己的阴影。

有关新粒子系统的完整细分,请阅读这篇 GeForce 文章。

每周,RTX AI Garage 系列博客都会为那些希望详细了解 NVIDIA NIM 微服务和 AI Blueprint 以及在 AI PC 和工作站上构建 AI 智能体、创意工作流、数字人、生产力应用等的用户提供社区驱动的 AI 创新和内容。

欢迎关注 NVIDIA 在微博、微信和哔哩哔哩的官方账号,获取最新资讯请订阅 RTX AI PC 新闻通讯。

请参阅有关软件产品信息的通知。