随着新模型包含更多功能,人们对生成式 AI 的兴趣不断增长。随着最新技术的发展,即使没有开发者背景的爱好者也可以直接使用这些模型。

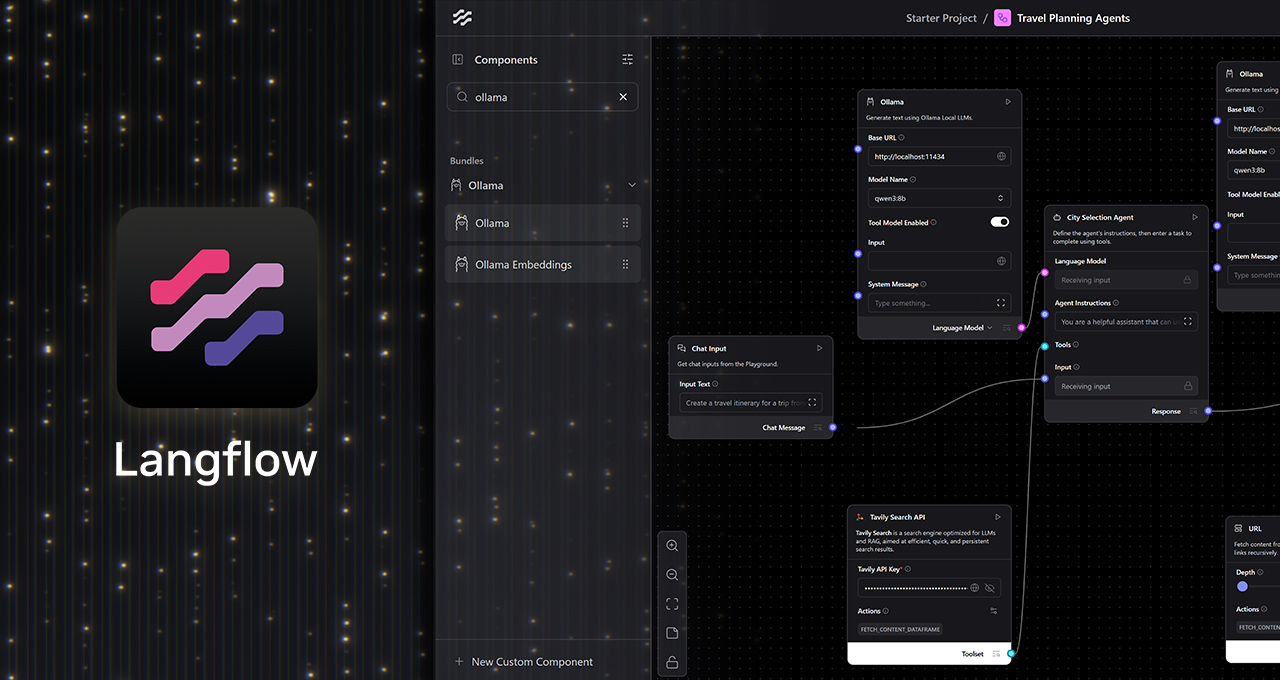

借助 Langflow(一个用于设计自定义 AI 工作流的低代码可视化平台)等流行的应用程序,AI 爱好者可以使用简单、无代码的用户界面 (UI) 来链接生成式 AI 模型。而且,通过 Ollama 的原生集成,用户现在可以在 NVIDIA GeForce RTX 和 RTX PRO GPU 的支持下,免费且完全私密地创建本地 AI 工作流。

生成式 AI 的可视化工作流

Langflow 提供了一个易于使用的画布式界面,在其中可以通过简单的拖放式 UI 连接生成式 AI 模型的组件,例如大语言模型(LLM)、工具、内存存储和控制逻辑。

这样无需手动编写脚本即可构建和修改复杂的 AI 工作流,从而简化能够制定决策和多步操作的智能体的开发。AI 爱好者可以轻松迭代和构建复杂的 AI 工作流,无需具备专业编程知识。

与只能运行单轮 LLM 请求的应用不同,Langflow 可以构建高级 AI 工作流,使其像智能协作者一样行动,能够分析文件、检索知识、执行功能并根据上下文对动态输入做出响应。

Langflow 可以从云端或本地运行模型,并通过 Ollama 获得 RTX GPU 的全面加速。在本地运行工作流具有多项关键优势:

- 数据隐私:输入、文件和提示词完全存于本地。

- 低成本且无需 API 密钥:由于不需要访问云端应用编程界面 (API),因此没有 Token 限制、无需服务订阅或与运行 AI 模型相关的成本。

- 性能:RTX GPU 即使在长上下文窗口下也能实现低延迟、高吞吐量的推理。

- 离线功能:本地 AI 工作流无需互联网即可访问。

使用 Langflow 和 Ollama 创建本地智能体

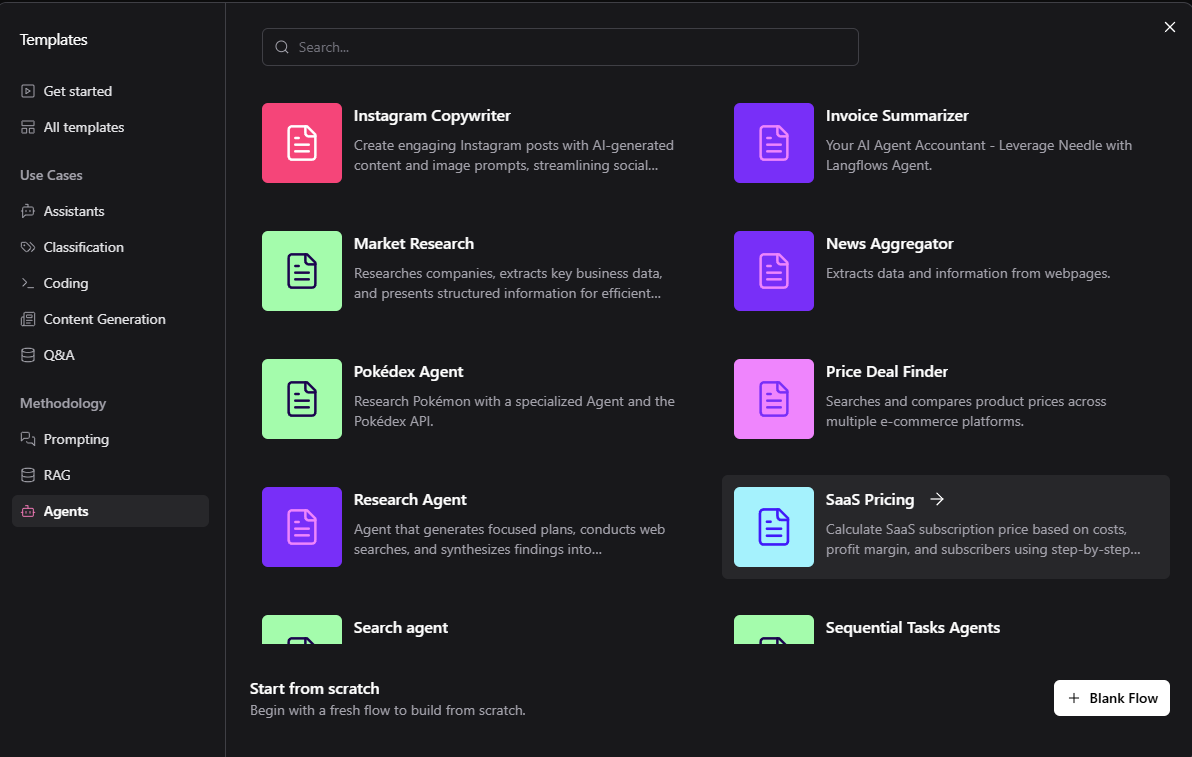

在 Langflow 中开始使用 Ollama 非常简单。 内置入门模板涵盖多种应用场景,从旅游代理到采购助理均可直接使用。默认模板通常在云端运行以进行测试,但可以通过 Langflow 对其进行定制,以在 RTX GPUs 上本地运行。

要构建本地工作流:

- 安装适用于 Windows 的 Langflow 桌面版应用。

- 安装 Ollama,然后运行 Ollama 并启动首选模型。

- 运行 Langflow 并选择一个启动器。

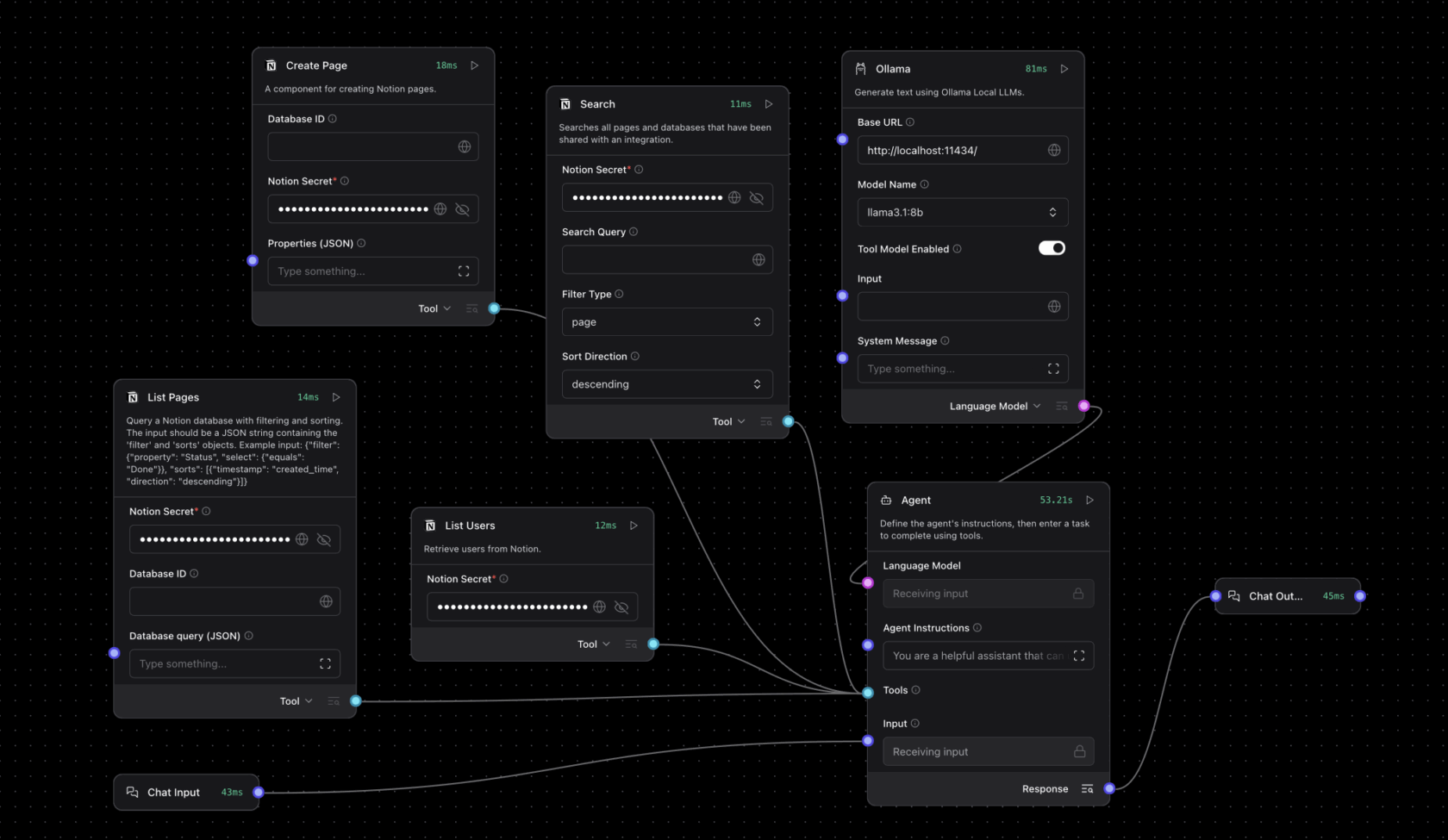

- 将云端入口替换为本地 Ollama 运行时。对于智能体工作流,将语言模型设置为自定义,将 Ollama 节点拖到画布,然后将智能体节点的自定义模型连接到 Ollama 节点的语言模型输出。

模板可以修改和扩展,例如添加系统命令、本地文件搜索或结构化输出,以满足高级自动化和助手用例。

观看 Langflow 团队的分步演示:

入门指南

以下是两个示例项目,供您开始探索。

创建个人旅行行程智能体:输入所有旅行要求(包括所需的餐厅预订、旅行者的饮食限制等),以自动查找和安排住宿、交通、餐饮和娱乐。

扩展 Notion 的功能:Notion 是一款用于组织项目的 AI 工作区应用,可通过 AI 模型进行扩展,实现自动输入会议记录、根据 Slack 聊天或电子邮件更新项目状态,以及发送项目或会议摘要。

RTX Remix 增加模型上下文协议,解锁智能体模组

RTX Remix 是一个开源平台,允许 Modder 通过生成式 AI 工具增强材质,并制作令人惊叹的、支持全景光线追踪和神经渲染技术的 RTX 重制版,该平台正在通过 LangFlow 增加对模型上下文协议 (MCP) 的支持。

支持 MCP 的 Langflow 节点为用户提供了一个使用 RTX Remix 的直接接口,让 Modder 能够构建能与 Remix 文档和模组功能进行智能交互的 mod 助手。

为帮助 Modder 入门,NVIDIA 的 Langflow Remix 模板包括:

- 带有 RTX Remix 文档的检索增强生成模组。

- 实时访问 Remix 文档,获得问答式支持。

- 通过 MCP 实现的操作节点,支持在 RTX Remix 中直接执行功能,包括资产替换、元数据更新和自动模组交互。

使用此模板构建的修改助手智能体可以确定查询是问答性的还是操作相关的。根据上下文,智能体会动态地给出指导或执行请求的操作。例如,用户可能会提示智能体:“将这个低分辨率纹理换为高分辨率版本。”然后,智能体将检查资产的元数据,找到合适的替代品,并使用 MCP 功能更新项目,无需人工交互。

RTX Remix 开发者指南中提供了 Remix 模板的文档和设置说明。

在 Langflow 中通过 Project G-Assist 控制 RTX AI PC

NVIDIA Project G-Assist 是一个实验性的本地 AI 助手,可在 GeForce RTX PC 上本地运行。用户只需输入简单的自然语言指令,即可查询系统信息(如PC 配置规格、CPU/GPU 温度及利用率)、调整系统设置及其他操作。

借助 Langflow 中的 G-Assist 组件,这些功能可以构建到自定义智能体工作流中。用户可以向 G-Assist 输入“获取 GPU 温度”或“调整风扇转速”,然后回复和操作将在他们的一系列组件中传输。

除了诊断和系统控制,G-Assist 还可通过其插件架构进行扩展,允许用户添加根据其工作流量身定制的新命令。社区构建的插件也可以直接从 Langflow 工作流调用。

要开始使用 Langflow 中的 G-Assist 组件,请阅读开发者文档。

Langflow 还是可作为 NVIDIA NeMo 微服务的开发工具,该微服务是一个模块化平台,用于在本地或云端 Kubernetes 环境构建和部署 AI 工作流。

通过 Ollama 和 MCP 的集成支持,Langflow 提供了一个实用的无代码平台,可构建完全离线并在设备上运行的实时 AI 工作流和智能体,并由 NVIDIA GeForce RTX 和 RTX PRO GPU 提供全面加速。

每周,RTX AI Garage 系列博客都会为那些希望详细了解 NVIDIA NIM 微服务和 AI Blueprint 以及在 AI PC 和工作站上构建 AI 智能体、创意工作流、数字人、生产力应用等的用户提供社区驱动的 AI 创新和内容。

欢迎关注 NVIDIA 在微博、微信和哔哩哔哩的官方账号,获取最新资讯请订阅 RTX AI PC 新闻通讯。

请参阅有关软件产品信息的通知。