今年,各行各业的企业都在纷纷推出 AI 服务。对于微软、Oracle、Perplexity、Snap 等数百家领先企业来说,使用 NVIDIA AI 推理平台(由世界领先的芯片、系统和软件组成的全堆栈)是实现高吞吐量、低延迟推理的关键,并且还能在降低成本的同时为用户带来卓越体验。

NVIDIA 凭借在推理软件优化和 NVIDIA Hopper 平台方面所取得的进步,正在帮助行业服务于最新的生成式 AI 模型,在提供出色的用户体验的同时,优化总体拥有成本。与前几代产品相比,Hopper 平台还可帮助推理工作负载实现高达 15 倍的能效提升。

AI 推理的难度众所周知,因为它需要经过许多步骤,才能在吞吐量和用户体验之间达成适当的平衡。

但其根本目标很简单:以更低的成本生成更多的 token。Token 代表大语言模型 (LLM) 系统中的单词,而 AI 推理服务通常按生成的每百万个 token 收费,这一目标能够给 AI 投资和每项任务所用能源带来最显著的回报。

全栈软件优化是提高 AI 推理性能和实现这一目标的关键。

以经济的方式提高用户吞吐量

企业经常面临着平衡推理工作负载性能与成本的挑战。有些客户或用例可以使用开箱即用的模型或托管模型,有些则可能需要使用定制模型。NVIDIA 技术可在简化模型部署的同时,优化 AI 推理工作负载的成本和性能。此外,客户还可以体验到他们选择部署的模型的灵活性和可定制性。

为了满足用户需求,NVIDIA 推出了 NVIDIA NIM 微服务、NVIDIA Triton 推理服务器和 NVIDIA TensorRT 库等推理解决方案:

- NVIDIA NIM 是一套用于部署 AI 模型的推理微服务,是一套易于使用的预构建容器工具,专为在一切基础设施(云、数据中心、边缘或工作站)上快速部署 AI 基础模型。

- NVIDIA Triton 推理服务器是 NVIDIA 最受欢迎的开源项目之一,允许用户将基于各类 AI 训练框架的模型封装并提供服务。

- NVIDIA TensorRT 是一个包含运行时和模型优化工具的高性能深度学习推理库,能够为生产级的应用实现低延迟、高吞吐量的推理。

NVIDIA AI Enterprise 软件平台包含以上所有解决方案,并提供企业级支持、稳定性、易管理性和安全性,可通过各大主要云应用市场获取。

借助与框架无关的 NVIDIA AI 推理平台,企业可节省生产力、减少开发工作并降低基础设施和设置成本。使用 NVIDIA 技术还能帮助企业避免停机和欺诈交易、提高电商购物转化率并开辟 AI 驱动的新收入渠道,从而增加企业的收入。

云上 LLM 推理

为了简化大语言模型的部署,NVIDIA 与各大云服务提供商密切合作,以确保只需极少的代码甚至无需代码就能在云端无缝部署 NVIDIA 推理平台。NVIDIA NIM 已经与云原生服务集成,包括:

- Amazon SageMaker AI、Amazon Bedrock Marketplace、Amazon Elastic Kubernetes Service

- Google Cloud’s Vertex AI、Google Kubernetes Engine

- Microsoft Azure AI Foundry 即将推出、Azure Kubernetes Service

- Oracle Cloud Infrastructure 的数据科学工具,Oracle Cloud Infrastructure Kubernetes Engine

此外,为了实现定制化的推理部署,NVIDIA Triton 推理服务器已经与各大云服务提供商深度集成。

例如在使用 OCI Data Science 平台部署 NVIDIA Triton 时,只需执行像在模型部署期间打开命令行参数中的开关一样简单的操作,就可以立即启动 NVIDIA Triton 推理端点。

同样,借助 Azure Machine Learning,用户可以通过 Azure Machine Learning Studio 进行 NVIDIA Triton 无代码部署,也可以通过 Azure Machine Learning CLI 进行全代码部署。AWS 为 SageMaker Marketplace 中的 NVIDIA NIM 提供一键部署,Google Cloud 在 Google Kubernetes Engine (GKE) 上提供一键部署选项。AWS 在其 AWS 深度学习容器上提供 NVIDIA Triton。

NVIDIA AI 推理平台还使用流行的通信方法来提供 AI 预测,并通过自动调整来满足基于云的基础架构中不断增长和变化的用户需求。

从加速 LLM 到改进创意工作流和改变协议管理,NVIDIA 的 AI 推理平台正在各个行业产生实际的影响。以下企业通过合作与创新将效率和可扩展性提升到新的水平。

与 Perplexity AI 的合作:每月处理 4 亿次搜索查询

Perplexity AI 是一款 AI 搜索引擎,每月处理的查询超过 4.35 亿次,而且每次查询都包含多个 AI 推理请求。为了满足这一需求,Perplexity AI 团队开始使用 NVIDIA Hopper GPU、Triton 推理服务器和 TensorRT-LLM。

Perplexity 支持 20 多个 AI 模型,包括 8B、70B 等 Llama 3 变体,能够处理搜索、摘要和问题解答等各种任务。通过使用较小的分类器模型将任务分流到 NVIDIA Triton 管理的各个 GPU pod,该公司在严格的服务水平协议下提供了经济高效、响应迅速的服务。

通过模型并行技术(将 LLM 分配到各个 GPU 上),Bing Perplexity 在保持低延迟和高准确性的同时,将成本降低至原来的三分之一。这一最佳实践框架展示了 IT 团队如何借助 NVIDIA 加速计算满足日益增长的 AI 需求、降低总体拥有成本并实现无缝扩展。

使用 Recurrent Drafter (ReDrafter) 缩短响应时间

开源研究的进步正在帮助实现 AI 推理的民主化。最近,NVIDIA 将 Apple 发布的推测解码开源方法 Redrafter 整合到 NVIDIA TensorRT-LLM 中。

ReDrafter 先使用较小的“draft”模块并行预测 token,然后由主模型对 token 进行验证。这项技术大大缩短了 LLM 的响应时间,尤其是在低流量期间。

与 Docusign 的合作:改变协议管理

数字协议管理领域的领先企业 Docusign 借助 NVIDIA 为其智能协议管理平台提供超强助力。Docusign 在全球拥有超过 150 万客户,该公司需要在优化吞吐量和管理基础设施支出的同时,提供 AI 驱动的洞察。

NVIDIA Triton 提供了一个适用于所有框架的统一推理平台,通过将协议数据转换成可操作的洞察,加快产品上市时间并提高生产力。Docusign 使用 NVIDIA 推理平台突显出可扩展的 AI 基础设施对客户体验和运营效率所产生的积极影响。

Docusign 高级产品经理 Alex Zakhvatov 表示:“NVIDIA Triton 让我们的生活变得更加轻松。我们不再需要为 AI 模型部署特定框架的定制推理服务器,而是可以将 Triton 作为所有 AI 框架的统一推理服务器,并使用它来确定正确的生产场景,以此优化降低成本和节省性能的工程项目。”

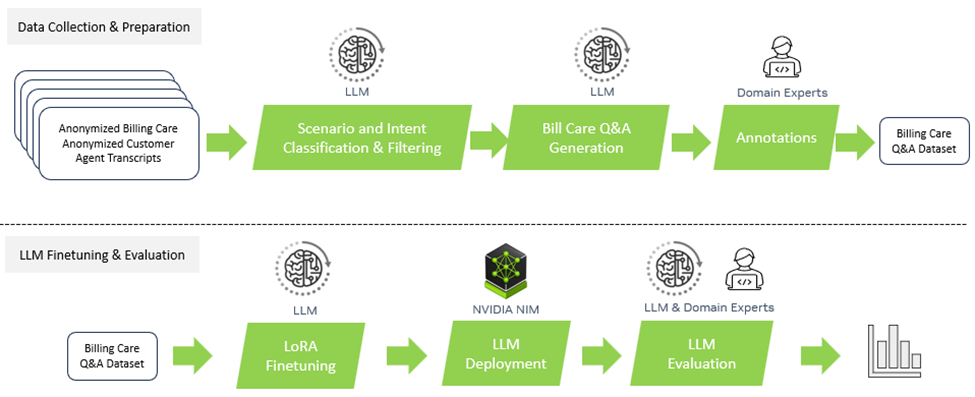

与 Amdocs 的合作:提升电信行业的客户服务

Amdocs 是一家为通信和媒体服务商提供软件和服务的领先供应商,该公司为电信企业构建的特定领域生成式 AI 平台 amAIz 是一个开放、安全、经济且与 LLM 无关的框架。Amdocs 正在使用 NVIDIA DGX Cloud 和 NVIDIA AI Enterprise 软件提供基于商用 LLM 和领域适配模型的解决方案,使服务提供商能够构建和部署企业级生成式 AI 应用。

通过使用 NVIDIA NIM,Amdocs 部署的用例在数据预处理和推理中消耗的 token 数量分别减少了 60% 和 40%,并根据不同的因素和使用量,在保证准确性不变的前提下大幅降低了单位 token 的成本。双方还一同将查询延迟降低了约 80%,确保终端用户体验到接近实时的响应。这一加速提升了用户在商务、客服、运营等方面的体验。

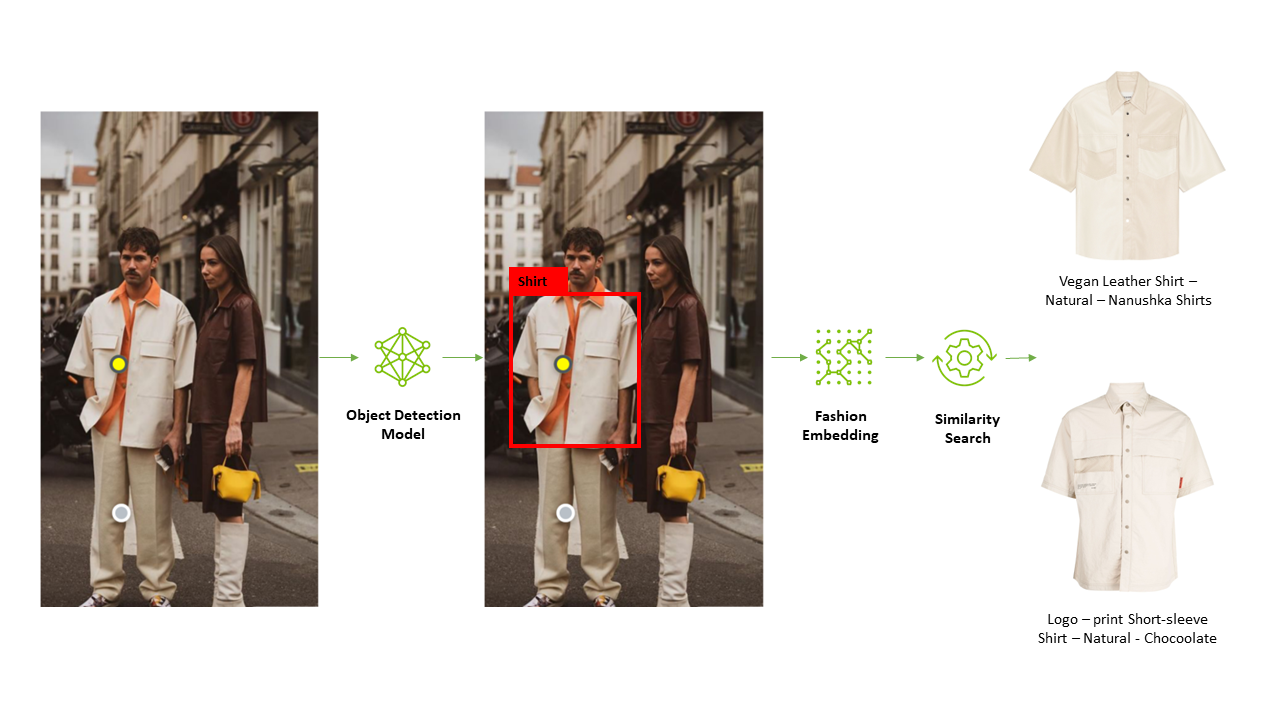

与 Snap 的合作:利用 AI 革新零售业态

Snap 的 Screenshop 功能让购买完美服装变得空前简单。这款由 AI 驱动的工具集成在 Snapchat 中,可帮助用户找到照片中的时尚单品。NVIDIA Triton 在实现 Screenshop 的流程方面发挥着关键作用,该流程使用包括 TensorFlow 和 PyTorch 在内的多个框架来处理图像。

Snap 将其流程整合到一个推理服务平台上,大大减少了开发时间和成本,同时还能够无缝部署更新后的模型,实现了 AI 驱动的顺畅用户体验。

Snap 的机器学习工程师 Ke Ma 解释道:“我们不想为我们的 Screenshop 流程部署定制推理服务平台,也不想分别为 TensorFlow 和 PyTorch 部署 TF 服务平台和 TorchServe 平台。Triton 采用了与框架无关的设计并支持 TensorFlow、PyTorch 和 ONNX 等多种后端,对我们来说非常具有吸引力。借助它,我们只需要使用一个推理服务平台就能提供我们的端到端流程。这既降低了我们的推理服务成本,又减少了开发者在生产中更新模型所需的天数。”

在 NVIDIA Triton 上成功推出 Screenshop 服务之后,Ma 和他的团队开始使用 NVIDIA TensorRT 来进一步提高系统性能。在编译过程中应用 NVIDIA TensorRT 默认设置后,Screenshop 团队看到吞吐量立刻激增了 3 倍,成本预计降低了 66%。

与 Wealthsimple 的合作:借助 AI 实现财务自由

推理平台重新定义了其机器学习方法。通过将基础设施标准化,Wealthsimple 将模型交付时间从原来的数月缩短至 15 分钟以内,不仅彻底避免了停机时间,还能够让团队以服务的形式提供机器学习。

通过使用 NVIDIA Triton 并在 AWS 上运行其模型,Wealthsimple 的正常运行时间达到 99.999%,确保了对每年超过 1.45 亿笔交易作出无缝预测。该转变充分展现出强大的 AI 基础设施为金融服务带来变革。

Wealthsimple 高级软件开发经理 Mandy Gu 表示:“NVIDIA 的 AI 推理平台一直是我们公司在 ML 领域取得成功的关键。它彻底改变了我们的模型部署方式,减少了停机时间,使我们能够为客户提供无与伦比的服务。”

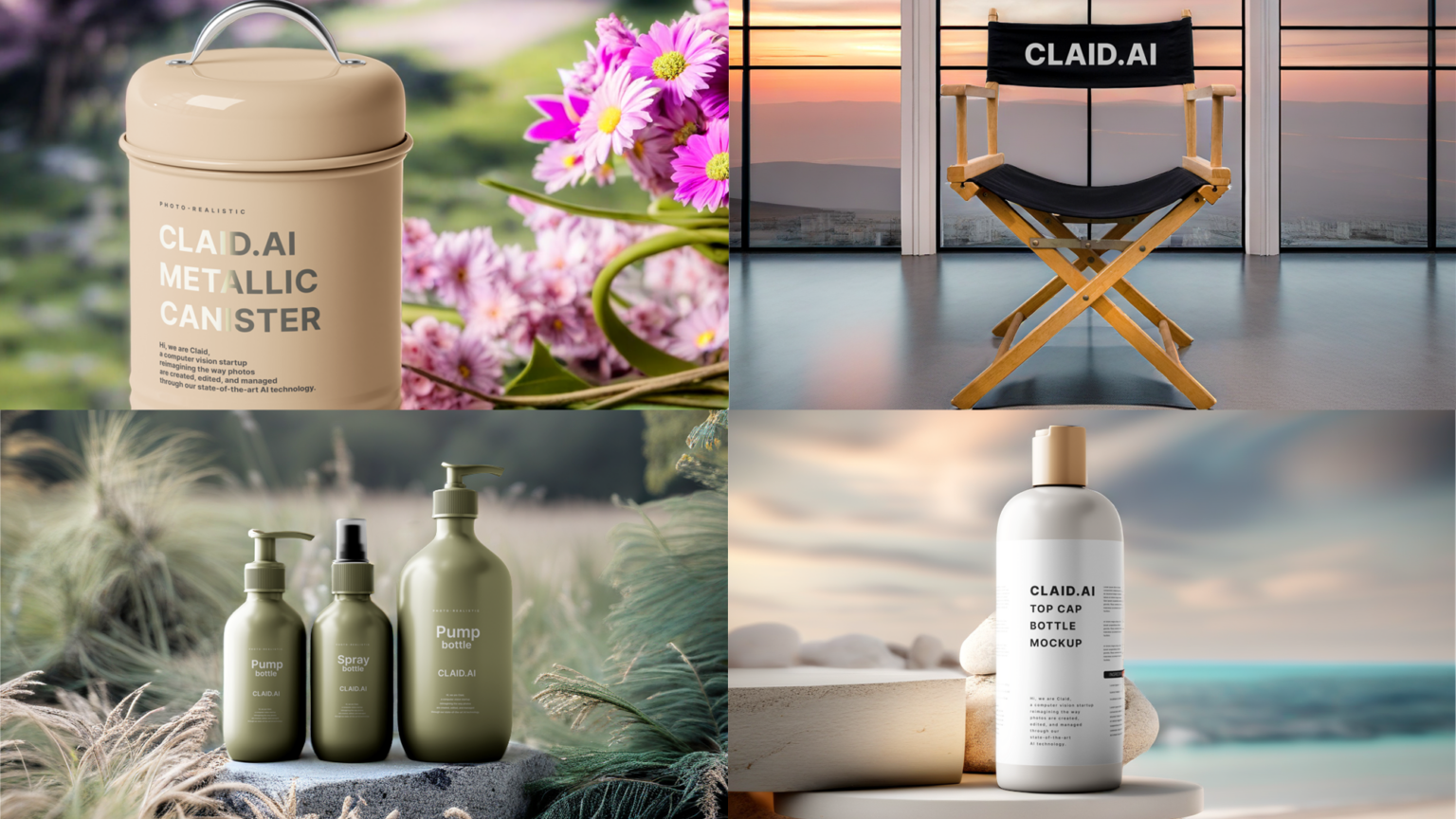

与 Let’s Enhance 的合作:提升创意工作流

AI 驱动的图像生成改变了创意工作流并且可以应用于企业用例,例如为营销视觉效果创建个性化内容和富有想象力的背景等。虽然扩散模型是改进创意工作流的强大工具,但这些模型的计算成本很高。

为了在生产中使用 Stable Diffusion XL 模型优化工作流,领先的 AI 初创公司 Let’s Enhance 选择了 NVIDIA AI 推理平台。

Let’s Enhance 的最新产品 AI Photoshoot 使用 SDXL 模型将普通产品照片转换成适用于电商网站和营销活动的精美视觉资产。

借助 NVIDIA Triton 对各种框架和后端的强大支持及其动态批处理功能集,Let’s Enhance 能够将 SDXL 模型无缝集成到现有的 AI 管线中并最大程度地减少工程团队的参与,使他们能够腾出时间进行研发工作。

与 OCI 的合作:加速云端视觉 AI

为驱动其视觉 AI 服务,Oracle Cloud Infrastructure (OCI) 集成了 NVIDIA Triton,将预测吞吐量提高了 76%,并将延迟降低了 51%。这些优化提升了客户的应用体验,包括为交通机构实现收费自动化、为全球企业简化发票识别等。

凭借 Triton 与硬件无关的功能,OCI 扩展了自己的 AI 服务组合,通过其全球数据中心为客户提供了强大而高效的解决方案。

负责为 Oracle 内部和外部用户处理机器学习的 OCI 数据科学服务产品管理总监 Tzvi Keisar 表示:“我们的 AI 平台具有 Triton 感知能力,能够为我们的客户创造效益。”

与微软的合作:提高实时上下文智能水平和搜索效率

Azure 提供了最广泛的 NVIDIA AI 驱动和优化的虚拟机。这些虚拟机涵盖多代 NVIDIA GPU,包括 NVIDIA Blackwell 和 NVIDIA Hopper 系统。

在这一深厚的工程合作历史基础上,NVIDIA GPU 和 NVIDIA Triton 目前帮助加速 Microsoft 365 Copilot 中的 AI 推理。作为 Windows PC 上的专用物理键盘键,Microsoft 365 Copilot 将大语言模型的强大功能与企业专有数据相结合,为用户提供了提高创造力、生产力和技能的实时上下文智能。

微软必应(Bing)还使用 NVIDIA 推理解决方案应对延迟、成本和速度等挑战。通过集成 NVIDIA TensorRT-LLM 技术,微软极大提高了其深度搜索功能的推理性能,进一步优化了网页搜索结果。

深度搜索演示由微软提供

微软必应视觉搜索使世界各地的人们能够通过照片查找内容。该功能的核心是微软的 TuringMM 视觉嵌入模型,该模型将图像和文本映射到一个共享的高维空间。该模型需要处理全网数十亿张图片,因此性能至关重要。

微软必应使用 NVIDIA TensorRT 和 NVIDIA 加速库 (包括 CV-CUDA 和 nvImageCodec) 对 TuringMM 流程进行了优化,使速度提高了 5.13 倍,并且显著降低了总体拥有成本。

通过硬件创新解锁 AI 推理的全部潜力

提高 AI 推理工作负载的效率是一项涉及多个方面的挑战,需要同时在软硬件领域进行技术创新才能实现。

NVIDIA GPU 处于 AI 赋能的前沿领域,为 AI 模型提供高效率和高性能,而且是节能的 GPU:基于 NVIDIA Blackwell 架构的 NVIDIA 加速计算将万亿参数 AI 模型推理工作的单位 token 生成能耗降低至过去十年的十万分之一。

NVIDIA Grace Hopper 超级芯片使用 NVIDIA NVLink-C2C 将 NVIDIA Grace CPU 和 Hopper GPU 架构相结合,为各个行业带来了显著的推理性能提升。

利用 Meta Andromeda 行业领先的机器学习释放广告商价值

Meta Andromeda 正在使用这款超级芯片实现高效率、高性能的个性化广告检索。通过创建具有更高计算复杂性和并行性的深度神经网络,它在 Facebook 和 Instagram 上实现了特定细分市场 8% 的广告质量提升和 6% 的召回率提升。

凭借经过优化的检索模型以及具有低延迟、高吞吐量和显存 IO 感知能力的 GPU 运算器,Andromeda 的特征提取速度比之前基于 CPU 的组件提高了 100 倍。Meta 这种在检索阶段集成 AI 的方式在广告检索领域处于领先地位,解决了可扩展性和延迟等难题,为用户带来了更好的体验和更高的广告投资回报。

随着前沿 AI 模型规模的不断扩大,生成每个 token 所需的计算量也在增加。为了实时运行最先进的 LLM,企业需要多个 GPU 协同工作。NVIDIA 集合通信库 (NCCL) 等工具能够让多 GPU 系统以最短的通信时间在 GPU 之间快速交换大量数据。

未来的 AI 推理创新

未来的 AI 推理有望大幅提高性能并降低成本。

通过结合 NVIDIA 的软件、新技术和先进硬件,数据中心将能够处理日益复杂和多样化的工作负载。凭借更准确的预测、更快的决策和更好的用户体验,AI 推理将继续推动医疗、金融等行业的进步。

随着这些趋势的不断发展,企业必须与时俱进,使用最新推理优化来最大程度地发挥投资的作用,才能在 AI 时代保持竞争力。

详细了解 NVIDIA 如何提供突破性的推理性能成果,以及最新的 AI 推理性能更新。