DeepSeek-R1 是一个具备先进推理能力的开源模型。与直接给出答案不同,像 DeepSeek-R1 这样的推理模型会针对一个查询执行多次推理过程,运用思维链、共识以及搜索等方法,从而得出最佳答案。

执行这一系列推理步骤(通过逻辑推理得出最佳答案),这一过程称为测试时缩放。DeepSeek-R1 是这一缩放定律的典型范例,它充分展现出为何加速计算对于代理式 AI 推理的需求至关重要。

当模型能够以迭代的方式对问题进行“思考”时,它们会生成更多的输出 token,并且生成周期也会变长,模型的质量也会随之不断提升。对于像 DeepSeek-R1 这样的推理模型来说,要实现实时推理并提供更高质量的回复,就需要在测试阶段投入大量的计算资源,这也意味着需要进行更大规模的推理部署。

R1 在需要逻辑推理、推理能力、数学计算、编程以及语言理解等任务中展现了卓越的准确性,同时还具备极高的推理效率。

为帮助开发者安全地试验这些功能,并构建自己特定的智能体,拥有 6710 亿参数的 DeepSeek-R1 模型现以 NVIDIA NIM 微服务预览形式提供。在单个 NVIDIA HGX H200 系统上,DeepSeek-R1 NIM 微服务每秒能够输出高达 3872 个 token。

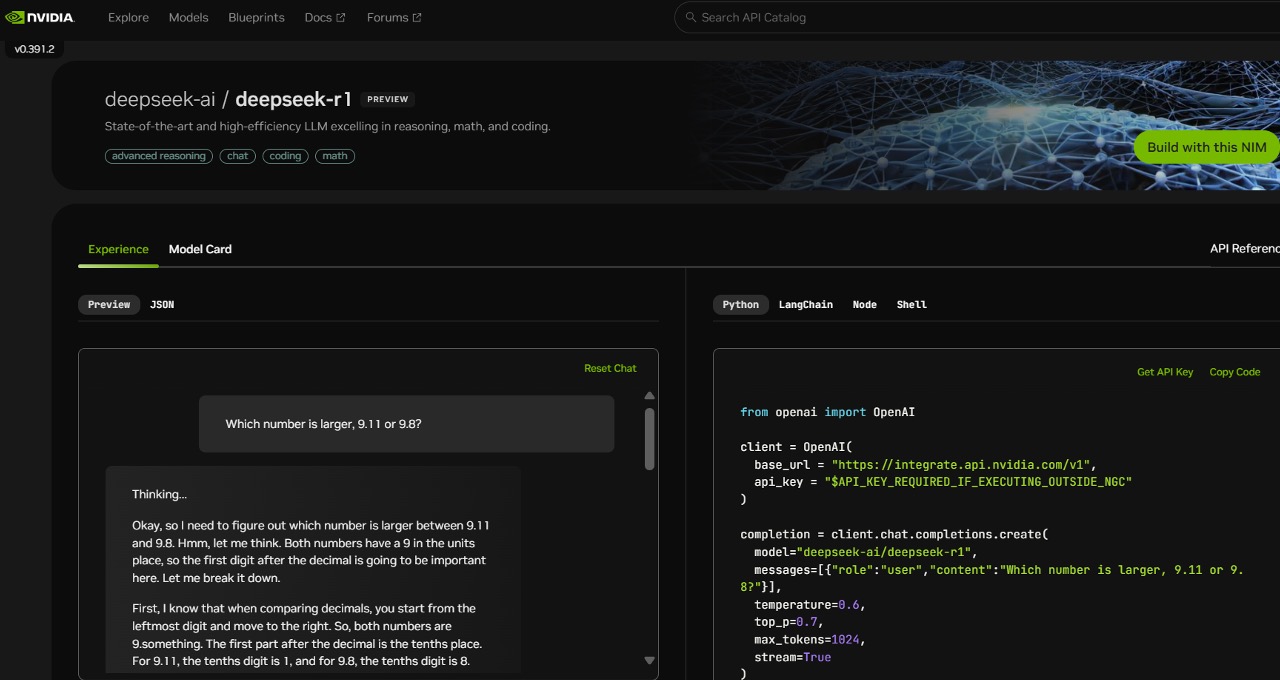

开发者可对应用程序编程接口 (API) 进行测试并试用。该 API 预计不久后将作为可下载的 NIM 微服务推出,它也是 NVIDIA AI Enterprise 软件平台的一部分。

DeepSeek-R1 NIM 微服务凭借对行业标准 API 的支持,极大地简化了部署流程。企业只需在其选定的加速计算基础设施上运行 NIM 微服务,便能最大限度地保障安全性和数据隐私。借助 NVIDIA AI Foundry 与 NVIDIA NeMo 软件,企业还能够为特定的 AI 智能体打造定制化的 DeepSeek-R1 NIM 微服务。

DeepSeek-R1 —— 测试时缩放的典型范例

DeepSeek-R1 是一款大型混合专家 (MoE) 模型。其参数数量达到了令人惊叹的 6,710 亿,是许多热门开源大语言模型 (LLMs) 的 10 倍之多,能够支持长达 128,000 token 的输入上下文。该模型每层所采用的专家数量也极为可观。R1 的每一层配备 256 个专家,每个 token 会被并行发送给 8 个不同的专家进行评估。

为了让 R1 实现实时回答,需要配备大量具备高性能计算能力的 GPU,并且这些 GPU 之间需通过高带宽、低延迟的通信链路相连接,以便将提示 token 分发给所有专家进行推理运算。借助 NVIDIA NIM 微服务中的软件优化技术,一台配置 8 个 H200 GPU 的服务器,通过 NVLink 和 NVLink Switch 连接,能够以每秒高达 3,872 个 token 的速度运行完整的、拥有 6,710 亿参数的 DeepSeek-R1 模型。这一卓越的吞吐量得益于在每一层都采用了 NVIDIA Hopper 架构的 FP8 Transformer 引擎,以及用于混合专家 (MoE) 通信、带宽达 900GB/s 的 NVLink 技术。

在实时推理过程中,充分挖掘 GPU 每秒浮点运算次数 (FLOPS) 的性能潜力至关重要。下一代 NVIDIA Blackwell 架构将凭借第五代张量核心 (Tensor Cores) 以及专为推理优化的 72-GPU NVLink 域,为 DeepSeek-R1 这类推理模型的测试时缩放能力带来飞跃式提升。第五代张量核心的峰值 FP4 计算性能可达 20 千万亿次浮点运算,而 72-GPU NVLink 域则在优化推理性能方面发挥着关键作用 。

即刻开启 DeepSeek-R1 NIM 微服务之旅

开发者们现在 NVIDIA 官网即可体验 DeepSeek-R1 NIM 微服务。

借助 NVIDIA NIM,企业能够轻松部署 DeepSeek-R1,确保代理式 AI 系统获得所需的高效性能。查阅相关软件产品信息说明。