通过与 OpenAI 协作,NVIDIA 针对 NVIDIA GPU 优化了该公司的全新开源 gpt-oss 模型,实现从云端到 PC 端的智能快速推理。这些全新推理模型为网络搜索、深度研究等代理式 AI 应用提供支持。

随着 gpt-oss-20b 和 gpt-oss-120b 的发布,OpenAI 为数百万用户带来了尖端模型。AI 爱好者和开发者可以在 NVIDIA RTX AI PC 和工作站上通过 Ollama、llama.cpp 和 Microsoft AI Foundry Local 等热门工具和框架使用优化模型。

NVIDIA 创始人兼 CEO 黄仁勋表示:“OpenAI 向世界展示了借助 NVIDIA AI 进行构建的潜力,现在正在推动开放源代码软件的创新。gpt-oss 模型让世界各地的开发者能够在此先进的开放源代码基础上进行构建,这一切都离不开 AI 计算基础设施。”

这些模型的发布凸显了 NVIDIA AI 从训练到推理、从云端到 AI PC 的领导地位。

向所有人开放

gpt-oss-20b 和 gpt-oss-120b 都是灵活的开放权重推理模型,具有思维链功能,可使用热门的专家混合架构调整推理效果。这些模型旨在为指令遵循和工具使用等特性提供支持,并使用 NVIDIA H100 GPU 进行了训练。AI 开发者可以通过 NVIDIA 技术博客中的说明了解详情并开始使用。

这些模型可以支持高达 131,072 的上下文长度,是本地推理中上下文最长的模型。这意味着模型可以通过上下文问题进行推理,是网络搜索、编码辅助、文档理解和深度研究等任务的理想选择。

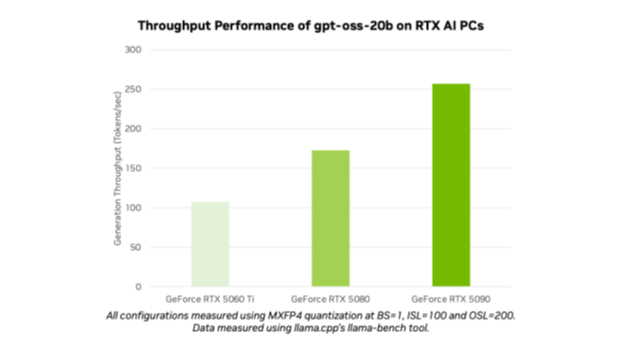

OpenAI 开放式模型是首批支持在 NVIDIA RTX 上运行的 MXFP4 模型。MXFP4 可以实现高模型质量,提供快速、高效的性能,同时比其他精度类型占用的资源更少。

借助 Ollama 在 NVIDIA RTX 上运行 OpenAI 模型

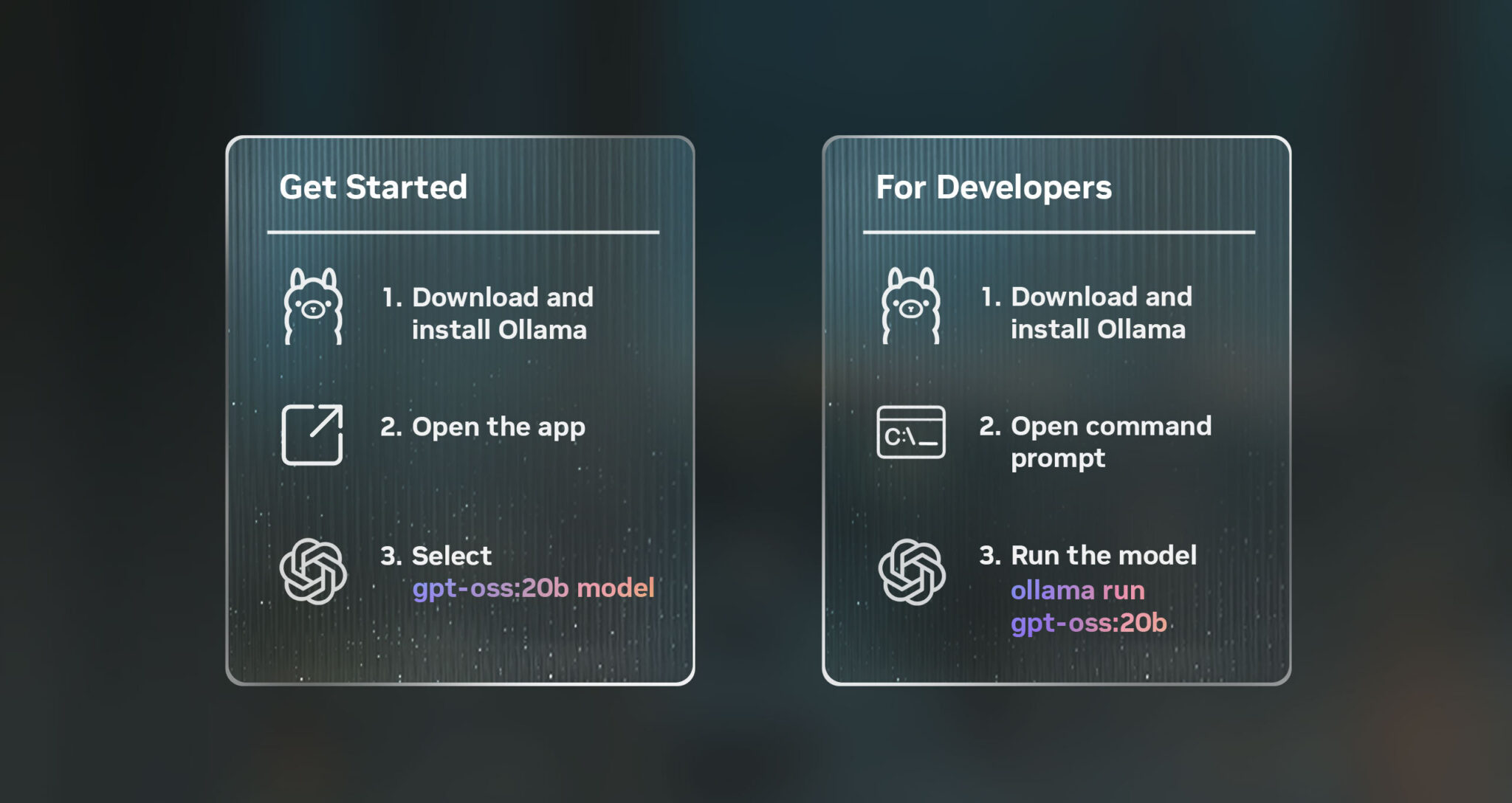

要在搭载 24GB 及以上显存的 GPU 的 RTX AI PC 上测试这些模型,最简单方法是使用全新的 Ollama 应用。Ollama 因易于集成而广受 AI 爱好者和开发者的欢迎,而其全新用户界面 (UI) 对 OpenAI 的开放权重模型提供开箱即用的支持。Ollama 针对 RTX 进行了全面优化,是希望在 PC 或工作站上体验个人 AI 强大功能的消费者的理想选择。

安装 Ollama 后,就可以与模型快速、轻松地聊天。只需从下拉菜单中选择模型并发送消息即可。由于 Ollama 针对 RTX 进行了优化,无需额外的配置或命令即可确保在支持的 GPU 上实现卓越性能。

Ollama 的新应用还包括其他新特性,例如在聊天中轻松支持 PDF 或文本文件,对适用模型提供多模态支持以便用户可以在提示词中添加图像,以及可以在处理大型文档或聊天时轻松定制上下文长度。

开发者还可以通过命令行界面或应用的软件开发套件 (SDK) 使用 Ollama,为应用和工作流提供助力。

在 RTX 上使用全新 OpenAI 模型的其他方式

爱好者和开发者还可以通过由 RTX 提供支持的各种其他应用和框架,在搭载 16GB 及以上显存的 GPU 的 RTX AI PC 上试用 gpt-oss 模型。

NVIDIA 继续与开放源代码社区在 llama.cpp 和 GGML 张量库方面展开合作,以优化 RTX GPU 的性能。近期的贡献包括通过集成 CUDA Graphs 降低开销,以及添加了降低 CPU 开销的算法。请查看 llama.cpp GitHub 库,以便入门。

Windows 开发者还可通过 Microsoft AI foundry Local(当前处于公开预览阶段)访问 OpenAI 的新模型。Foundry Local 是一个端侧 AI 推理解决方案,可通过命令行、SDK 或应用编程界面集成到工作流中。Foundry Local 采用通过 CUDA 优化的 ONNX 运行时,即将推出对 NVIDIA TensorRT for RTX 的支持。入门非常简单:安装 Foundry Local,然后在终端中调用 “Foundry model run gpt-oss-20b”。

对于希望在其 AI 加速 Windows 应用中添加推理功能的爱好者和开发者来说,这些开放源代码模型的发布开启了下一个 AI 创新浪潮。

每周,RTX AI Garage 系列博客都会为那些希望详细了解 NVIDIA NIM 微服务和 AI Blueprint 以及在 AI PC 和工作站上构建 AI 智能体、创意工作流、数字人、生产力应用等的用户提供社区驱动的 AI 创新和内容。

欢迎关注 NVIDIA 在微博、微信和哔哩哔哩的官方账号,获取最新资讯请订阅 RTX AI PC 新闻通讯。

请参阅有关软件产品信息的通知。