生成式 AI 正在将 PC 软件转变为突破性体验——从数字人到写作助手、智能体与创意工具。

NVIDIA RTX AI PC 和正在驱动这一变革,相关技术让用户更轻松地探索生成式 AI,并在 Windows 11 上释放更强性能。

TensorRT 已为 RTX AI PC 重新设计,将业界领先的 TensorRT 性能与即时编译 (Just-In-Time) 的本地引擎构建模式相结合,封装体积缩小至原来的 1/8,使 AI 功能能够快速部署至超过 1 亿台 RTX AI PC 上。

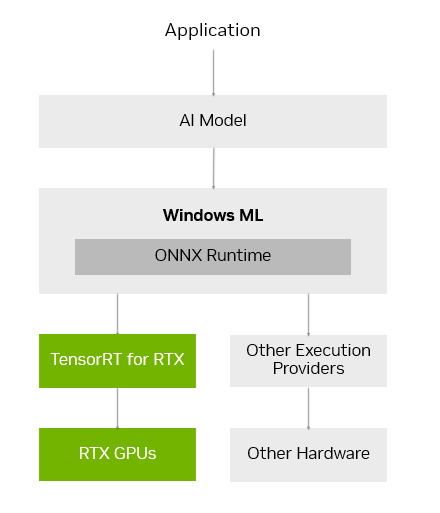

Microsoft Build 微软开发者大会上公布,TensorRT for RTX 得到 Windows ML 原生支持。这一全新推理框架为应用开发者提供广泛的硬件兼容性与业界领先的性能表现。

NVIDIA 发布的 SDK 让应用开发者更轻松地集成 AI 功能,并在 GeForce RTX GPU 上为应用加速。本月来自 Autodesk、哔哩哔哩、Chaos、LM Studio 和 Topaz 的多款主流软件应用将发布更新,解锁 RTX AI 功能与加速能力。

AI 发烧友与开发者可通过 NVIDIA NIM 轻松上手 AI 开发。这是一套预包装、优化好的 AI 模型,能够在 AnythingLLM、Microsoft VS Code 和 ComfyUI 等主流应用中运行。现已推出 FLUX.1-schnell 图像生成模型的 NIM 版本,热门的 FLUX.1-dev NIM 也已更新,支持更多 RTX GPU。对于希望零代码入门 AI 开发的用户,Project G-Assist 是一款RTX PC AI助手,它提供了一种简单的方式来通过构建插件创建助手工作流。目前已有多个社区插件上线,包括 Google Gemini 网页搜索、Spotify、Twitch、IFTTT 和 SignalRGB等。

TensorRT for RTX 为 AI 推理加速

当下的 AI PC 软件栈要求开发者做出取舍:选择硬件支持广泛但性能较低的框架,或性能优化但只支持特定硬件/模型,需开发者维护多种实现路径。

全新的 Windows ML 推理框架为解决这些难题设计。Windows ML 基于 ONNX Runtime 构建,可无缝连接由各硬件厂商提供和维护的优化 AI 执行层。

在 GeForce RTX GPU 上,Windows ML 会自动调用 TensorRT for RTX。这是一款专为高性能和快速部署优化的推理库。与 DirectML 相比,TensorRT 在 PC 端 AI 工作负载中可带来超过 50% 的性能提升。

Windows ML 在使用便捷性上的优势让开发者受益匪浅。它可自动选择合适的硬件运行各 AI 功能,并下载对应的执行程序,无需将相关文件打包进应用程序中。这使得 NVIDIA 能够第一时间将最新的 TensorRT 性能更新推送给用户。基于 ONNX Runtime 构建,Windows ML 可兼容任意 ONNX 模型。

为进一步提升开发者体验,TensorRT 已针对 RTX 平台进行了重新设计。开发者无需再预生成 TensorRT 引擎并随应用打包发布,TensorRT for RTX 采用即时执行 (Just-In-Time) 的本地引擎构建模式,在数秒内针对用户的 RTX GPU 进行 AI 模型运行优化。该库大幅精简,体积缩小了整整 8 倍。TensorRT for RTX 现已通过 Windows ML preview 向开发者开放,并将在 6 月作为独立 SDK 通过 NVIDIA Developer 正式发布。

开发者可通过以下渠道了解更多信息:NVIDIA Microsoft Build 开发者博客、TensorRT for RTX 发布博客,以及 Microsoft 的 Windows ML 官方博客。

扩展 Windows 11 PC 上的 AI 生态系统

开发者若希望为应用添加 AI 功能或提升性能,可利用 NVIDIA 丰富的 SDK 工具套件。这些包括用于 GPU 加速的 CUDA 与 TensorRT,用于 3D 图形的 DLSS 与 OptiX,用于多媒体处理的 RTX Video 与 Maxine,以及用于生成式 AI 的 Riva、Nemotron 与 ACE。

本月,多款热门应用发布更新,借助 NVIDIA 软件开发工具包 (SDK) 实现专属功能:

- LM Studio 已发布更新,升级至最新 CUDA 版本,性能提升超 30%。

- Topaz 将推出一款用于提升视频画质的生成式AI视频模型,通过 CUDA 加速。

- Chaos Enscape 与 Autodesk VRED 将加入 DLSS 4 支持,实现更高性能与图像质量。

- 哔哩哔哩将集成 NVIDIA Broadcast 功能,使主播能在哔哩哔哩直播姬应用中直接启用 NVIDIA 虚拟背景,从而提升直播质量。

NVIDIA 期待继续与微软及领先人工智能应用开发者合作,通过 Windows ML 与 TensorRT 的集成,助力应用在搭载 RTX 技术的设备上加速人工智能功能。

NIM 微服务与 AI Blueprint 让本地 AI 开发更轻松

AI 开发起步对于 PC 用户来说往往十分繁琐。AI 开发者和发烧友需要从 Hugging Face 上超过 120 万个模型中筛选合适模型,将其量化为适合自己 PC 运行的格式,配置并安装各种依赖,步骤繁多。

NVIDIA NIM 让这一切变得简单:它提供精心挑选的 AI 模型,预封装所需全部文件,并经过优化,可在 RTX GPU 上以最高性能运行。作为容器化微服务,NIM 可在 PC 与云端之间无缝运行。

NVIDIA NIM 微服务可通过 build.nvidia.com 或主流 AI 应用,如 Anything LLM、ComfyUI 和适用于 Visual Studio Code 的 AI Toolkit下载。

在即将举行的 Computex 大会上,NVIDIA 将发布 FLUX.1-schnell NIM——由 Black Forest Labs 打造的高速图像生成模型,并更新FLUX.1-dev NIM,拓展其对 GeForce RTX 50 与 40 系列 GPU 的广泛兼容性。

这些 NIM 通过 TensorRT 实现更高性能,量化模型也得到进一步加速。在 Blackwell GPU 上,得益于 FP4 与 RTX 优化,其运行速度是原生模型的两倍以上。

AI 开发者还可以通过 NVIDIA AI Blueprint——基于 NIM 的示例工作流与项目框架快速启动项目。上月,NVIDIA 发布了 3D 引导生成式 AI Blueprint,该方案可通过 3D 场景作为参考,精准控制生成图像的构图与视角。开发者可根据自身需求修改这一开源蓝图,或扩展其功能。

全新 Project G-Assist 插件与示例项目现已上线

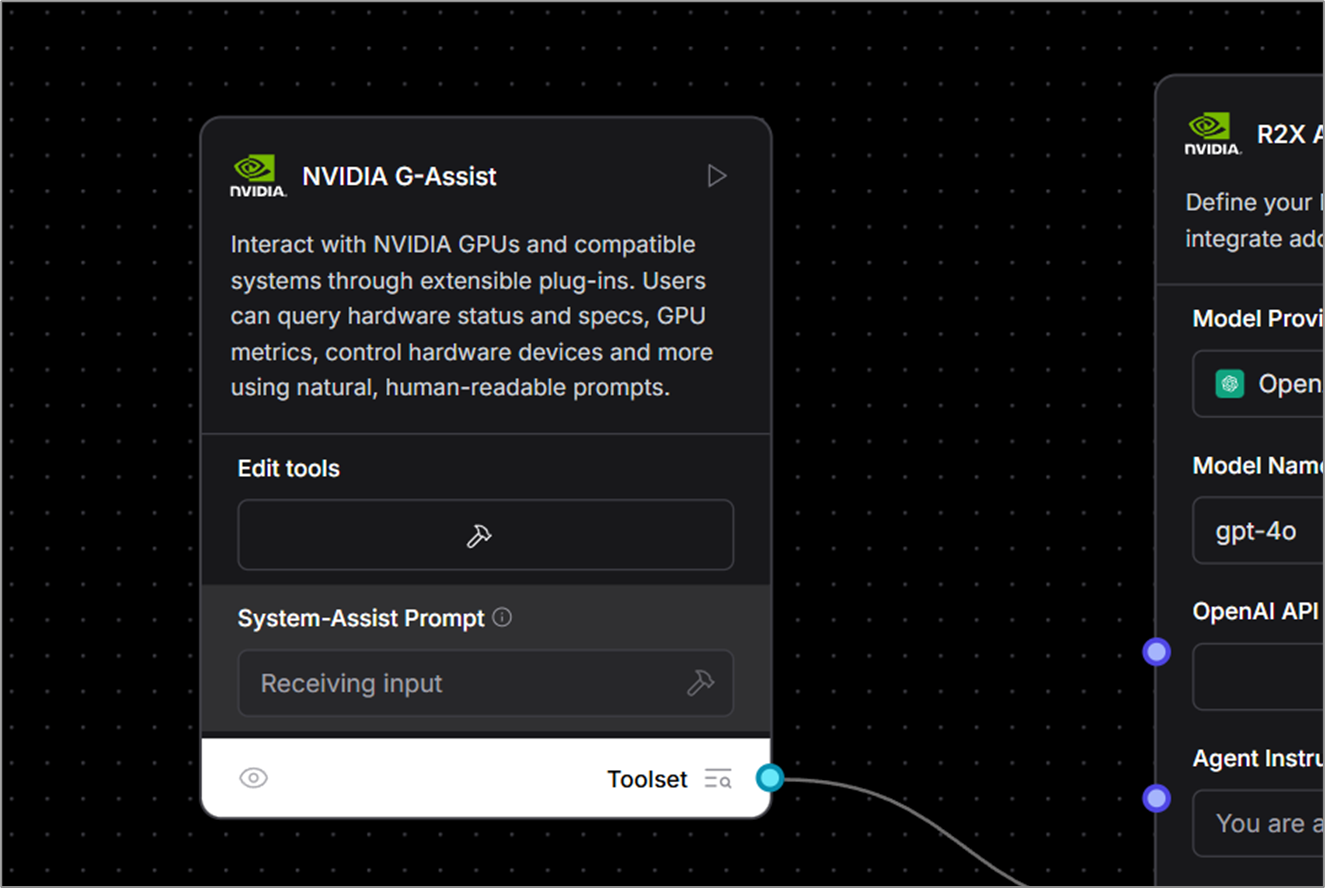

NVIDIA 近期推出了 Project G-Assist,一个试验性 AI 助手功能。G-Assist 让用户可通过简单的语音或文本指令控制 GeForce RTX 系统,相较于传统多个控制面板的手动操作界面,更加便捷直观。

开发者可利用 Project G-Assist 轻松构建插件、测试助手使用场景,并通过 NVIDIA 在 Discord 与 GitHub 上的官方账号发布。

为方便用户上手开发插件,NVIDIA 现已提供简便易用的“插件构建器” (Plug-in Builder)——一个基于 ChatGPT 的应用,支持零代码/低代码开发,仅通过自然语言指令即可生成插件。这些轻量化、社区驱动的插件采用简单的 JSON 结构与 Python 逻辑编写。

多款全新开源示例现已上线 GitHub,展示本地 AI 如何增强 PC 与游戏体验:

- Gemini:现有 Gemini 插件已更新,新增对 Google 免费云端 LLM 的实时网页搜索功能。

- IFTTT:支持接入数百个 IFTTT 端点,包含 IoT 与智能家居设备,实现数字系统与物理环境联动的自动化流程。

- Discord:玩家在不中断游戏的情况下,可便捷分享游戏高光时刻或消息至 Discord 服务器。

前往 GitHub 探索更多示例插件,包括通过 Spotify 实现免手操作音乐控制、使用 Twitch 进行直播状态检查等。

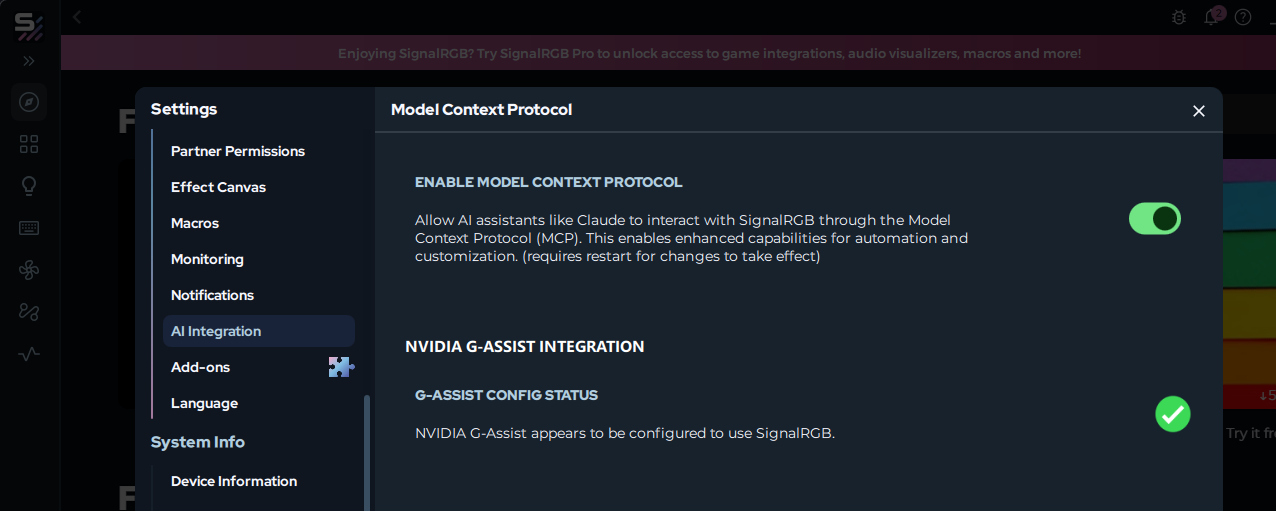

越来越多厂商也开始采用 AI 作为 PC 的新交互方式。例如,SignalRGB 正开发 G-Assist 插件,实现多品牌设备间的统一灯效控制。SignalRGB 用户不久后将可直接通过 SignalRGB APP 安装此插件。

从本周起,AI 开发者社区将能够在 Langflow 中以自定义组件形式使用 G-Assist 插件——从而让用户能够在低代码或零代码工作流、AI 应用及智能体流程中集成函数调用功能。

欢迎对 Project G-Assist 插件开发与实验感兴趣的发烧友加入 NVIDIA Developer Discord 社区,参与合作、分享作品,并获得支持。

每周,RTX AI Garage 博客系列都会分享由社区推动的 AI 创新与内容,面向希望深入了解 NIM 微服务、AI Blueprint,以及如何在 AI PC 和工作站上构建 AI 智能体、创意工作流、数字人、生产力应用等的用户。

欢迎关注 NVIDIA 在微博、微信和哔哩哔哩的官方账号,获取最新资讯请订阅 RTX AI PC 新闻通讯。

请查看软件产品信息服务条款。