案例简介

本案例中美团机器学习平台使用 NVIDIA GPU 支持其多方面优化策略,从而提高吞吐能力及降低响应延迟。通过算子融合、计算图等价替换等一系列优化 ,相较于 CPU 在相同成本约束下,NVIDIA T4 GPU 大幅加速美团 CTR(Click-Through-Rate)模型预测性能,神经网络模型吞吐能力提升了 10 倍;同时在搜索精排场景中,端到端整体吞吐能力提升了一倍以上,助力美团 CTR 向新一代服务升级。

• 本案例为 NVIDIA GPU 推理加速互联网行业 CTR 模型的典型应用

• 本案例主要应用到 T4 GPU 和 NVIDIA 各 SDK 以及 CUDA 加速手段

客户简介及应用背景

美团是一家集生活服务及商品零售的电商平台,公司聚焦“零售+科技”战略,以“吃”为核心,通过科技创新,服务于生活服务业需求侧和供给侧数字化升级。美团在中国业务涵盖餐饮、配送、网约车、共享单车、酒店及旅游预订、电影票务等 200 多个服务品类,覆盖全国 2800 个市区县,服务 6.7 亿活跃用户和 830 万活跃商家。

伴随着用户规模的提升和业务的精细化运营,业务侧对推荐系统的准确度、吞吐能力和时延都提出了新的挑战,而 CTR 模型作为推荐系统的核心模型,其效果直接影响业务的收入。

客户挑战

美团的 CTR 模型过去一直在使用 CPU 推理的方式,但随着用户访问量的提升和深度神经网络的引入,CTR 模型结构趋于复杂,吞吐和计算量也越来越大,CPU 开始不能满足模型对于算力的需求,而仅仅通过 CPU 服务器的堆叠带来的性能提升性价比相较偏低。

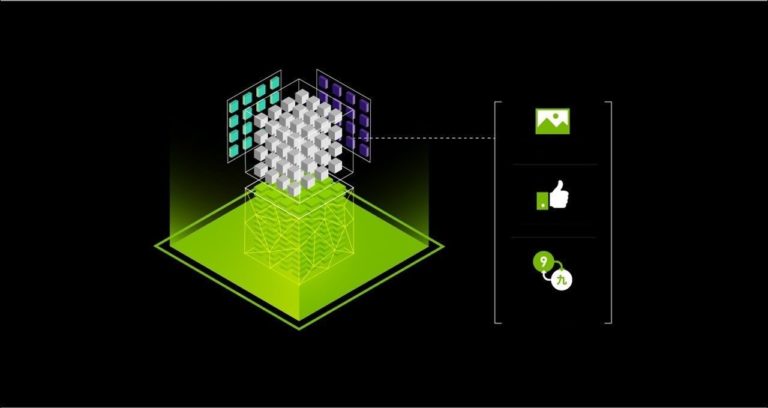

而 GPU 拥有数以千计的计算核心,可以在单机内提供密集的并行计算能力,特别适合深度学习场景,在行业内已经在 CV、NLP 等领域展示了强大的能力。通过 CUDA 及相关 API,NVIDIA建立了完整的 GPU 生态系统。基于此,美团基础研发平台将 CTR 模型部署到 GPU 上,并通过一系列针对 CPU 与 GPU 的异构系统并行计算设计、数据存储方式和传输方式上的特定优化,希望能通过 GPU 强大的计算力,协助美团在 CTR 预测的各业务场景中发挥出最大优势。

应用方案

为了解决算力瓶颈及上述各种挑战,美团机器学习平台采用 NVIDIA AI 计算平台,在继 CV、NLP 及 CTR 训练后,也使用了 NVIDIA T4来提供 CTR 预测支持,大幅提升用户体验与服务稳定性。除此之外,时延也是业务侧非常重视的性能指标,许多复杂模型纵有更好的准确度,但却因响应时间不达标而无法落地应用,例如,在某搜索框自动补全的场景,由于天然的交互属性,时延要求非常苛刻,一般来说无法使用复杂的模型。而在 GPU 能力的加持下,其复杂模型的平均响应时间从 15 毫秒降低至 6~7 毫秒,足足缩短了一倍多,达到了上线要求。

使用效果及影响

通过 NVIDIA T4 深度优化方案,成功为美团 CTR 模型创造更多应用机会,不仅极大地提升了系统吞吐量,更进一步地提升了整个模型训练的速度与降低训练成本,落实 AI 框架在 GPU 上性能推理的优化实践。

“在美团和英伟达的共同努力下,我们将 CTR 预测服务成功的迁移到 GPU 平台上,在为业务提供更好的支撑的同时也获得了更好的性价比;下一步,机器学习平台计划采用 NVIDIA Triton 推理服务框架和 NVIDIA Ampere A30,进一步提升美团推理服务的效率。”

王新、美团研发工程师,机器学习平台预测引擎负责人