美国加利福尼亚州圣何塞 —— GTC —— 太平洋时间 2025 年 3 月 18 日 ——NVIDIA 今日宣布推出 NVIDIA Blackwell AI 工厂平台的新一代产品 —— NVIDIA Blackwell Ultra,开启了 AI 推理新时代。

NVIDIA Blackwell Ultra 提升了训练和测试时扩展推理能力(test-time scaling inference), 即通过在推理过程中增加计算量来提升准确率的技术,以帮助全球各地的企业加速AI推理、代理式AI及物理AI等应用的开发与部署。

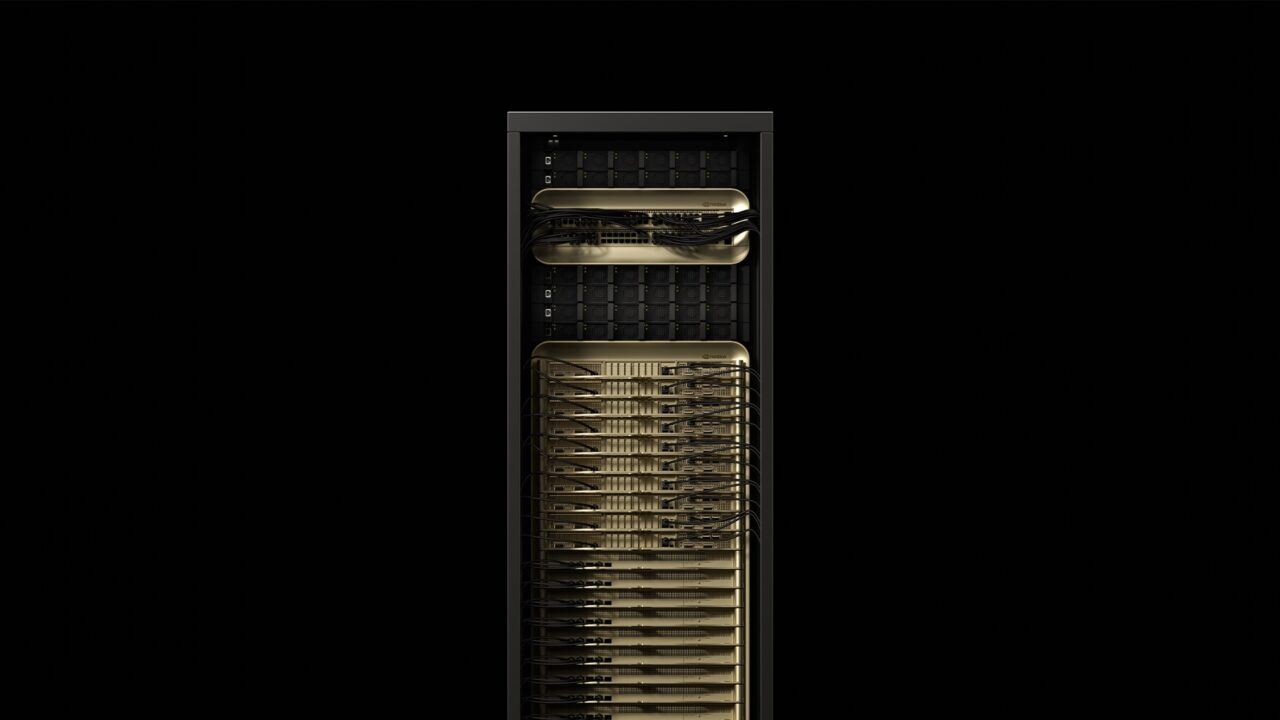

基于一年前推出的突破性的 Blackwell 架构,Blackwell Ultra 包括 NVIDIA GB300 NVL72 机架级解决方案和 NVIDIA HGX™ B300 NVL16 系统。 GB300 NVL72 的 AI 性能是NVIDIA GB200 NVL72 的 1.5 倍,这使得建造 AI 工厂 的收入机会与基于 NVIDIA Hopper™ 构建的系统相比增加了 50 倍。

“人工智能实现了巨大的飞跃 —— 推理和代理式AI对计算性能的需求呈数量级增长,”NVIDIA创始人兼首席执行官黄仁勋表示。“我们为这一时刻设计了 Blackwell Ultra —— 它是一款单一且多功能的平台,能够轻松高效地完成预训练、后训练以及推理型AI推理任务。”

NVIDIA Blackwell Ultra 实现 AI 推理

NVIDIA GB300 NVL72 在一个机架设计中连接了 72 个 Blackwell Ultra GPU 和 36 个基于Arm Neoverse 架构的 NVIDIA Grace™ CPU,整体表现如同一个巨型 GPU,专为测试时扩展而打造。通过 GB300 NVL72,AI 模型能够利用平台增强的计算能力探索多种解决方案,将复杂请求分解为多个步骤,从而生成更高质量的响应。

GB300 NVL72 预计还将通过 NVIDIA DGX™ Cloud 提供,该平台是一个端到端的全托管 AI 平台,部署于领先的云服务上,通过软件、服务和 AI 专业知识为不断发展的工作负载优化性能。配备 DGX GB300 系统的 NVIDIA DGX SuperPOD™ 采用 GB300 NVL72 机架设计,为客户提供了一个交钥匙式 AI 工厂。

NVIDIA HGX B300 NVL16 相比 Hopper 代产品,LLM 推理速度提速了 11 倍,计算性能提升了 7 倍,内存容量扩大了 4 倍,可为最复杂的工作负载(如 AI 推理)提供突破性性能。

此外,Blackwell Ultra 平台特别适用于以下应用:

- 代理式 AI, 利用复杂推理和迭代规划自主解决复杂的多步骤问题。 AI 智能体系统超越了简单的指令执行。 他们能够推理、规划并采取行动以实现特定目标。

- 物理 AI,使企业能够实时生成合成的、具有高度真实感的视频,用于大规模训练机器人和自动驾驶汽车等应用。

NVIDIA 横向扩展基础架构以实现绝佳性能

先进的横向扩展型网络是 AI 基础架构的重要组成部分,可在降低延迟和抖动的同时提供卓越性能。

Blackwell Ultra 系统与 NVIDIA Spectrum-X™ 以太网 和 NVIDIA Quantum-X800 InfiniBand 平台无缝集成,通过 NVIDIA ConnectX®-8 SuperNIC 为系统中的每个 GPU 提供 800 Gb/s 的数据吞吐率。 这为 AI 工厂和云数据中心提供了极佳的远程直接内存访问(RDMA)能力,使其能够无瓶颈地处理 AI 推理模型。

NVIDIA BlueField®-3 DPU,作为 Blackwell Ultra 系统的重要组件,能够实现多租户网络架构、GPU 计算资源弹性扩展、数据访问加速以及实时网络安全检测 。

全球技术领导者拥抱 Blackwell Ultra

合作伙伴预计将从 2025 年下半年开始推出基于 Blackwell Ultra 的产品。

思科、戴尔科技、慧与、联想和超微预计将推出基于 Blackwell Ultra 的各类服务器,此外还包括 Aivres、华擎、华硕、Eviden、Foxconn、技嘉科技、英业达、和硕、云达科技(QCT)、纬创和纬颖科技。

云服务提供商亚马逊云科技(AWS)、谷歌云、微软 Azure 和 Oracle Cloud Infrastructure(OCI),以及 GPU 云提供商 CoreWeave、Crusoe、Lambda、Nebius、Nscale、Yotta 和 YTL 将成为首批提供 Blackwell Ultra 支持实例的供应商。

NVIDIA 软件创新减少 AI 瓶颈

全部 NVIDIA Blackwell 产品组合都得到 NVIDIA AI 全栈平台支持。 今天同时发布的 NVIDIA Dynamo 开源推理框架可扩展推理 AI 服务,通过提供最高效的测试时计算扩展解决方案,得以实现吞吐量的飞跃,同时降低响应时间和模型服务成本。

NVIDIA Dynamo 是全新的 AI 推理服务软件,旨在为部署推理 AI 模型的 AI 工厂最大化 token 收益。它可以协调和加速数千个 GPU 之间的推理通信,并使用分离式服务在不同的 GPU 上分离大语言模型的预处理和生成阶段。这使得每个阶段都能根据其特定需求进行独立优化,确保 GPU 资源利用率最大化。

Blackwell 系统非常适合运行全新的 NVIDIA Llama Nemotron 推理模型和 NVIDIA AI-Q Blueprint,这些都得到用于生产级 AI 的 NVIDIA AI Enterprise 软件平台支持。 NVIDIA AI Enterprise 软件平台包括 NVIDIA NIM™ 微服务,以及企业可以在 NVIDIA 加速的云、数据中心和工作站上部署的 AI 框架、库和工具。

Blackwell 平台建立在 NVIDIA 强大的开发工具生态系统之上,包括 NVIDIA CUDA-X™ 库、超过 600 万开发者和 4,000 多个可跨数千 GPU 扩展性能的应用程序。

更多信息,请观看 NVIDIA GTC 主题演讲,并在 3 月 21 日前注册参加由 NVIDIA 和行业领导者带来的会议。

关于 NVIDIA

NVIDIA (NASDAQ: NVDA) 是加速计算领域的全球领导者。

本新闻稿中的某些声明,包括但不限于有关 NVIDIA 产品、服务和技术的优势、影响、可用性和性能的声明;第三方采用或提供 NVIDIA 产品和技术的声明; Blackwell Ultra 能够轻松高效地完成预训练、后训练以及推理型AI推理任务的声明;以及先进网络建设是 AI 基础设施的关键组件、可在降低延迟和抖动的同时提供顶级性能的声明,均为前瞻性声明,存在可能导致实际结果与预期有重大差异的风险和不确定性。可能导致实际结果产生重大差异的重要因素包括:全球经济状况;我们依靠第三方来制造、组装、包装和测试我们的产品;技术发展和竞争的影响;新产品和技术的开发或者现有产品升级;我们产品或合作伙伴产品的市场认可度;设计、制造或软件缺陷;消费者偏好或需求的变化;行业标准和接口变化;我们产品或技术在集成到系统中时发生的意外性能损失;NVIDIA 向美国证券交易委员会(SEC)提交最新报告中不时详述的其他因素,这些报告包括(但不限于)采用 10-K 表的年度报告和采用 10-Q 表的季度报告。向 SEC 提交的报告的副本均在 NVIDIA 的官方网站上发布,并可免费下载。以上前瞻性陈述并非未来表现的保证,仅以本协议日期为准;除法律要求外,NVIDIA不承担更新以上前瞻性陈述以反映未来事件或情况的任何义务。

本文描述的许多产品和功能仍处于不同阶段,其提供与否将取决于具体情况。 上述声明不旨在、也不应被解释为承诺、保证或法律义务。我们产品所述的任何特性或功能的开发、发布和时间安排均可能发生变化,并由 NVIDIA 全权决定。 对于未能交付或延迟交付本文所述的任何产品、特性或功能,NVIDIA 不承担任何责任。

© 2025 NVIDIA Corporation. 保留一切权利。NVIDIA、NVIDIA 商标、BlueField、Connect-X、CUDA-X、NVIDIA DGX、NVIDIA DGX SuperPOD、NVIDIA Grace、NVIDIA HGX、NVIDIA Hopper、NVIDIA NIM 和 NVIDIA Spectrum-X 均为 NVIDIA Corporation 在美国和/或其他国家/地区的商标和/或注册商标。 其他公司名称和产品名称可能是与其相关的各家公司的商标。功能、定价、可用性和规格如有更改,恕不另行通知。