一家世界领先技术公司并不会每天都重点介绍其他公司的产品优势。

在过去的一周中,英特尔只是比较了 NVIDIA GPU 的两个最昂贵的 CPU 的推理性能。

为了实现单个主流 NVIDIA V100 GPU 的性能,英特尔结合了两个功耗较高的高端 CPU,根据 Anandtech,后者的估计价格为 5 万美元 – 10 万美元。英特尔做出的性能比较也突出了 NVIDIA T4 GPU 的明显优势,这些 GPU 专为推理而构建。与单个高端 CPU 相比,它们不仅更快,而且还拥有高达 7 倍的能效和更具成本效益的订单量。

推理性能至关重要,因为 AI 驱动的服务呈指数级增长。英特尔最新的 Cascade Lake CPU 包括可改善推理的新指令,从而使它们成为最佳的推理 CPU。不过,它们难以匹敌 NVIDIA 深度学习优化 Tensor 核心 GPU。

推理(也称为预测)在很简单的情况下是一种“模式识别”,它是一种在训练后的神经网络。AI 模型可以在应用程序中提供智能功能,例如在金融交易中检测欺诈行为,通过自然语言对话以搜索互联网,甚至在生产故障发生之前就可以通过预测分析进行修复。

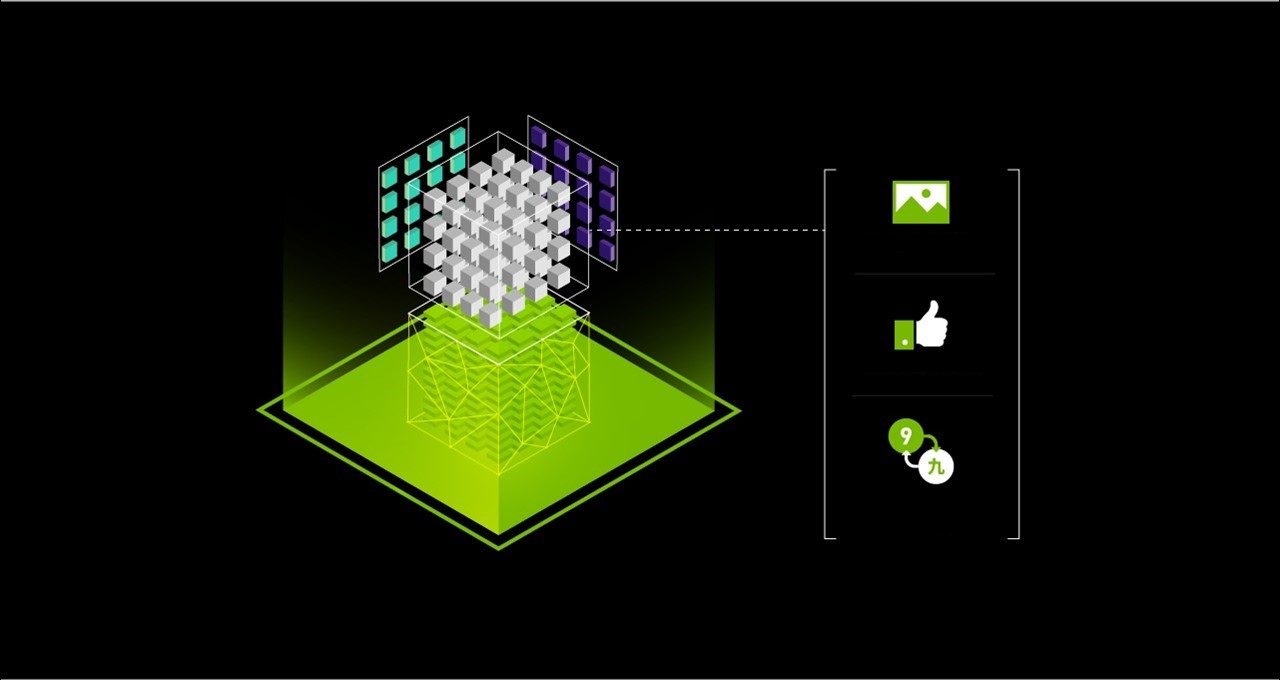

虽然现在的大多数 AI 推理都是在 CPU 上进行的,但 NVIDIA Tensor 核心 GPU 正在迅速用于各种 AI 模型。Tensor 核心是一种突破性的创新技术,其已将 NVIDIA GPU 转变为高效率和卓越的 AI 处理器。Tensor 核心以高速率进行多精度计算,为不同的 AI 模型提供最佳精度,并在热门 AI 框架中实现自动支持。

如今,越来越多的消费型互联网公司(如 Microsoft、Paypal、Pinterest、Snap 和 Twitter)正在采用 GPU 进行推理。

适用于计算机视觉的 Tensor 核心 GPU 极具吸引力的价值

首次推出 NVIDIA Volta 架构后,Tensor Core GPU 现已推出 NVIDIA Turing 的第二代产品。Tensor 核心对 AI 进行了极其高效的计算,从 16 位浮点运算 32 位累积到 8 位,甚至是 32 位累积的 4 位整数运算。

其设计旨在加速 AI 训练和推理,并且可以在 TensorFlow 和 PyTorch 框架中使用自动混合精度功能。开发人员可以只需要将两行代码添加到他们的 TensorFlow 项目中,就可以实现 3 倍的训练速度。

在计算机视觉上,如下表所示,在比较相同数量的处理器时,NVIDIA T4 的速度更快,7 倍更高能效并且更经济实惠。NVIDIA V100 是专为 AI 训练设计的,比 CPU 推理快了 2 倍,能效提高了 2 倍。

表 1:ResNet-50 上的推理。

|

双插槽 英特尔至强 9282 |

NVIDIA V100 (Volta) |

NVIDIA T4 (Turing) |

ResNet-50 推理(图像/秒) |

7,878 |

7,844 |

4,944 |

处理器数量 |

2 |

1 |

1 |

总处理器 TDP |

800 W |

350 W |

70 W |

能源效率(时间 TDP) |

10 图像/秒/W |

22 图像/秒/W |

71 图像/秒/W |

每个处理器的性能(图像/秒) |

3,939 |

7,844 |

4,944 |

GPU 性能优势 |

1.0 (基准) |

2.0 倍 |

1.3 倍 |

GPU 能效优势 |

1.0 (基准) |

2.3 倍 |

7.2 倍 |

适用于理解自然语言的 Tensor 核心 GPU 极具吸引力的价值

AI 一直以疯狂的节奏发展。这种快速进展由 AI 研究人员和数据科学家团队不断加速,他们不断创新并创造高度准确、复杂度呈指数级增长的 AI 模型。

四年前,来自 Microsoft 的 AI 使用 ResNet-50 等模型能够以超人的准确度执行的早期应用程序之一就是计算机视觉。如今的高级模型会执行更复杂的任务,例如以超人的准确度理解语言和语音。去年,BERT 在 Google 上开放的高度复杂的 AI 模型现在可以理解散文,并用超人的准确度回答问题。

AI 模型的复杂程度的衡量指标是它们拥有的参数数量。AI 模型中的参数是存储模型所学信息的变量。虽然 ResNet-50 有 0.25 亿个参数,但 BERT 有 3.4 亿个,提高了 13 倍。

在 BERT 等高级模型上,单个 NVIDIA T4 GPU 的速度比双插槽 CPU 服务器快 59 倍,能效提高了 240 倍。

表 2:BERT 上的推理。 工作负载: BERT 大数据集微调推理。

|

双路英特尔至强 Gold 6240 |

NVIDIA T4 (Turing) |

BERT 推理, 问题 – 回答(句子/秒) |

2 |

118 |

处理器 TDP |

300 W (150 Wx2) |

70 W |

高能效(使用 TDP) |

0.007 句/秒/W |

1.7 句/秒/W |

GPU 性能优势 |

1.0 (基准) |

59 倍 |

GPU 能效优势 |

1.0 (基准) |

240 倍 |

CPU 服务器:双插槽至强 Gold 6240 @ 2.6 GHz;384GB 系统 RAM;FP32 精度;英特尔的 TF Docker 容器 v。1.13.1.注意:批大小 4 产生了最佳 CPU 分数。

GPU 结果:T4:双插槽至强 Gold 6240,2.6 GHz;384GB 系统 RAM;混合精度;CUDA 10.1.105;NCCL 2.4.3、cuDNN 7.5.0.56、cuBLAS 10.1.105;NVIDIA 驱动程序 418.67;在 TensorFlow 上使用自动混合精度和 XLA 编译器;适用于所有已测试平台的批大小 4 和序列长度 128。

适用于推荐系统的 Tensor 核心 GPU 极具吸引力的价值

AI 的另一个主要用途是推荐系统,用于提供有关视频共享网站、社交网站上的新闻源以及电子商务网站上的产品建议等相关内容。

神经联合过滤(或 NCF)是一种推荐系统,使用之前用户与项目之间的交互来提供推荐。在 NCF 模型上运行推理时,如果该模型属于 MLPerf 0.5 训练基准测试,NVIDIA T4 实现的性能是 CPU 的 10 倍,能效是 CPU 的 20 倍。

表 3:NCF 上的推理。

|

单路英特尔至强 Gold 6240 |

NVIDIA T4 (Turing) |

推荐推理吞吐量 (MovieLens) (数千个样本/秒) |

2,860 |

27,800 |

处理器 TDP |

150 W |

70 W |

高能效(使用 TDP) |

19 个样本/秒/W |

397 个样本/秒/W |

GPU 性能优势 |

1.0 (基准) |

10x |

GPU 能效优势 |

1.0 (基准) |

20x |

CPU 服务器:单插槽至强 Gold 6240,2.6 GHz;384GB 系统 RAM;使用适用于 TensorFlow 上的 NCF 的 英特尔基准测试,英特尔的 TF Docker 容器版本 1.13.1;FP32 精度。注意:单插槽 CPU 配置用于 CPU 测试,因为它生成的分数比双插槽更好。

GPU 结果:T4:单插槽至强 Gold 6140,2.3 GHz;384GB 系统 RAM;CUDA 10.1.105;NCCL 2.4.3、cuDNN 7.5.0.56、cuBLAS 10.1.105;NVIDIA 驱动程序 418.40.04;在 TensorFlow 上使用自动混合精度和 XLA 编译器;批大小:2048 用于 CPU,1048576 用于 T4;精度:FP32 用于 CPU,混合精度用于 T4。

适用于 AI 训练和推理的统一平台

在应用程序中使用 AI 模型是一种为持续改进性能而设计的迭代过程。数据科学家团队利用新的数据和算法不断更新其模型,以提高准确性。然后,开发人员会在应用程序中更新这些模型。

可以每月、每周甚至每天进行一次更新。为 AI 训练和推理提供单一平台可以大幅简化和加速在应用程序中部署和更新 AI 的这一过程。

如标准 AI 基准测试 MLPerf 所示,NVIDIA 的数据中心 GPU 计算平台在性能方面处于行业领先地位,在 AI 训练方面具有较大利润空间。NVIDIA 平台为推理提供了极具吸引力的价值,此处提供的数据能够证明这一点。这种价值会随着现代 AI 的复杂性和进展的不断增长而增加。

为了进一步提高在 AI 方面的快速进展,NVIDIA 加强了生态系统合作,并不断优化软件,包括 TensorFlow、Pytorch 和 MxNet 等关键框架,以及 TensorRT 和 TensorRT 推理服务器等推理软件。

NVIDIA 还会定期发布预先训练的 AI 模型,用于推理和模型脚本,以便使用您自己的数据训练模型。所有此类软件均可免费提供给容器,可以从 NVIDIA 的 GPU 加速软件中心 NGC 下载并运行。

充分了解我们的全面 AI 平台。