NVIDIA DGX SuperPOD 正为基于 NVIDIA Rubin 平台构建的大规模系统部署铺平道路,从而走向 AI 计算的下一次飞跃。

在 CES 上,NVIDIA 推出了 Rubin 平台,该平台由六款全新芯片组成,旨在打造一台超凡的 AI 超级计算机,专为加速代理式 AI、混合专家模型 (MoE) 以及长上下文推理而设计。

Rubin 平台通过先进的协同设计方法,将六款芯片——NVIDIA Vera CPU、Rubin GPU、NVLink 6 交换机、ConnectX-9 SuperNIC、BlueField-4 DPU 和 Spectrum-6 以太网交换机——进行了有机整合,从而加速训练过程并降低推理 token 生成成本。

不论是企业还是研究环境,DGX SuperPOD 都可作为部署基于 Rubin 系统的基础架构设计参考方案。

NVIDIA DGX 平台将从 NVIDIA 计算到网络再到软件的整个技术栈整合为一个统一协同的系统,消除了基础设施集成的负担,使团队能够专注于 AI 创新和业务成果。

NVIDIA 创始人兼首席执行官黄仁勋表示:“当前训练和推理的 AI 计算需求不断激增,Rubin 的问世恰逢其时。”

为 AI 产业革命打造的新平台

新 DGX 系统采用的 Rubin 平台引入了五项重大技术突破,旨在推动智能与效率实现阶跃式提升:

- 第六代 NVIDIA NVLink——每个 GPU 支持 3.6TB/s 的带宽,每个 Vera Rubin NVL72 机架总带宽达 260TB/s,可支持大规模 MoE 与长上下文工作负载。

- NVIDIA Vera CPU——采用了 88 颗 NVIDIA 定制 Olympus 核心打造,完全兼容 Armv9.2,并提供超高速 NVLink-C2C 连接能力,实现业界领先的高效 AI 工厂级计算能力。

- NVIDIA Rubin GPU——搭载具备硬件加速自适应压缩能力的第三代 Transformer 引擎,为 AI 推理提供 50 PFLOPS 的 NVFP4 运算能力。

- 第三代 NVIDIA 机密计算——Vera Rubin NVL72 是首个提供 NVIDIA 机密计算的机架级平台,能够在 CPU、GPU 和 NVLink 域之间的各个领域保障数据安全。

- 第二代 RAS 引擎——Rubin 平台涵盖 GPU、CPU 和 NVLink,具有实时运行状况检查、容错机制和主动维护等功能;采用模块化无线缆托盘设计,使装配和维护速度提升 18 倍。

这些创新技术共同实现了推理 token 成本最多可降至上一代平台的十分之一——随着 AI 模型在规模、上下文和推理深度上的不断扩展,这标志着一个关键里程碑。

DGX SuperPOD:为 NVIDIA Rubin 横向 (Scale-Out) 扩展提供蓝图

基于 Rubin 的 DGX SuperPOD 部署将集成:

- NVIDIA DGX Vera Rubin NVL72 或 DGX Rubin NVL8 系统

- NVIDIA BlueField- 4 DPU,用于构建安全、软件定义的基础设施

- NVIDIA 推理上下文记忆存储平台,支持下一代推理工作负载

- NVIDIA ConnectX-9 SuperNIC

- NVIDIA Quantum-X800 InfiniBand 与 NVIDIA Spectrum-X 以太网

- NVIDIA Mission Control,用于 AI 基础设施的自动化编排与运维

基于 DGX Vera Rubin NVL72 构建的 NVIDIA DGX SuperPOD,整合了八个 DGX Vera Rubin NVL72 系统,配备 576 个 Rubin GPU,可提供 28.8 ExaFlops 的 FP4 性能和 600TB 的高速内存。每个 DGX Vera Rubin NVL72 系统集成了 36 个 Vera CPU、72 个 Rubin GPU 和 18 个 BlueField‑4 DPU,可在机架范围内实现统一内存与计算空间。凭借 260TB/s 的 NVLink 聚合吞吐量,该系统消除了模型切分需求,使整个机架能够作为统一协同的 AI 引擎运行。

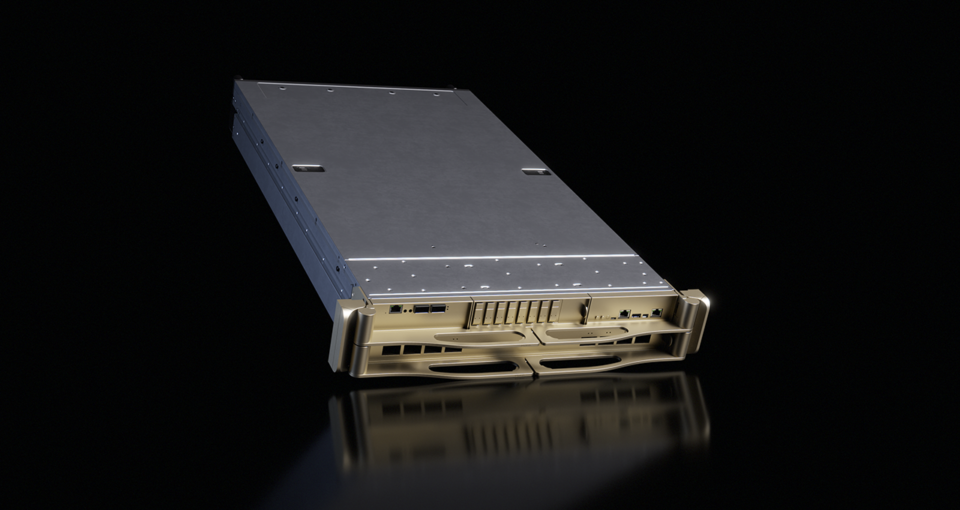

基于 DGX Rubin NVL8 系统构建的 NVIDIA DGX SuperPOD,由 64 台 DGX Rubin NVL8 系统组成,搭载了 512 个Rubin GPU。NVIDIA DGX Rubin NVL8 系统采用液冷架构,搭载 x86 CPU,为各类 AI 项目从开发到部署全流程提供强劲支撑,助力企业迈入 Rubin 时代。每台 DGX Rubin NVL8 配备八块 NVIDIA Rubin GPU 及第六代 NVLink 技术,其 NVFP4 浮点运算能力较 NVIDIA Blackwell 系统提升 5.5 倍。

面向 AI 工厂的下一代网络

Rubin 平台通过革命性网络架构重新定义了数据中心,将其打造为高性能 AI 工厂。该平台搭载 NVIDIA Spectrum-6 以太网交换机、NVIDIA Quantum-X800 InfiniBand 交换机、BlueField-4 DPU 及 ConnectX-9 SuperNIC,专为承载全球最庞大的 AI 工作负载而设计。通过将这些创新技术集成至 NVIDIA DGX SuperPOD,Rubin 平台彻底消除了传统架构在扩展性、拥塞及可靠性方面的瓶颈。

针对大规模集群优化的连接性能

新一代 800Gb/s 端到端网络套件为 AI 基础设施提供两条专用路径,无论采用 InfiniBand 还是以太网均能确保峰值效率:

- NVIDIA Quantum-X800 InfiniBand:为专用 AI 集群提供业界最低延迟与最高性能。采用 SHARP v4 (Scalable Hierarchical Aggregation and Reduction Protocol) 及自适应路由技术,将集合通信操作卸载到网络。

- NVIDIA Spectrum-X 以太网:基于 Spectrum-6 以太网交换机和 ConnectX-9 SuperNIC 构成,该平台采用标准以太网协议,为 AI 工厂提供可预测的高性能横向 (scale-out) 扩展与跨区域 (scale-across) 连接,并针对 AI 工作负载的“东西向”流量模式进行专项优化。

打造十亿瓦级 AI 工厂

这些创新代表了 Rubin 平台的极致协同设计。凭借对拥塞控制与性能隔离技术的掌控,NVIDIA 正为下一波十亿瓦级 AI 工厂铺平道路。这种整体化方案确保了当 AI 模型日益复杂时,AI 工厂的网络架构仍能成为速度的催化剂而非瓶颈。

NVIDIA 软件推动 AI 工厂运营与部署

NVIDIA Mission Control——专为基于 NVIDIA Blackwell 架构的 DGX 系统设计的 AI 数据中心运维与编排软件——现已支持基于 Rubin 架构的 NVIDIA DGX 系统,助力企业实现基础设施管理的自动化与运维自动化。

NVIDIA Mission Control 可在多方面加速基础设施运营,涵盖配置部署、设施集成、集群管理及工作负载调度。

借助智能集成软件,企业可更精准地掌控 NVIDIA Rubin 的冷却与供电事项,同时提升基础设施弹性。该平台通过快速泄漏检测实现更迅捷的响应,解锁 NVIDIA 最新能效创新技术,并凭借自主恢复功能最大化 AI 工厂的生产力。

NVIDIA DGX 系统还支持 NVIDIA AI Enterprise 软件平台,包括 NVIDIA NIM,例如用于 NVIDIA Nemotron-3 系列开放模型、数据和库。

DGX SuperPOD:工业 AI 的未来之路

DGX SuperPOD 长期以来一直是大型 AI 基础设施的蓝图。Rubin 平台的问世将成为新一代 AI 工厂的起点——这些系统旨在实现跨数千步推理,并以显著降低的成本交付智能,助力企业构建下一代尖端模型、多模态系统和代理式 AI 应用。

请参阅有关软件产品信息的声明。