得益于 Instagram 和 Snapchat 的出现,我们可以轻而易举地向图片和视频添加滤镜。但如果您想按照梵高的《星空》或蒙克的《呐喊》的风格来重新绘制智能手机视频呢?

为实现这一目标,一支来自德国弗赖堡大学的研究团队采用了名为“深度学习”的人工智能方法,目前已取得关键进展。

该团队开发出了一种方法,使用深度神经网络,从原始绘画作品中提取特定的艺术风格,然后将这种信息合成到单独的视频内容中。NVIDIA GPU 使这项计算密集型工作不再成为难题,并取得了卓越成果。

具有长期记忆的算法

之前的工作使用深度学习技术成功地在将一张图片的艺术风格应用到另一张图片中。早期的研究发现,深度神经网络处理图片时,它的神经活动可以对图片的笔触、色彩及其他抽象细节等风格信息进行编码。然后该网络就可以将这种风格应用于该网络认为的第二张图片的内容中。

但视频中有许多移动的画面。将静态图片的风格传递技术应用到视频的每一帧上就没那么简单了。

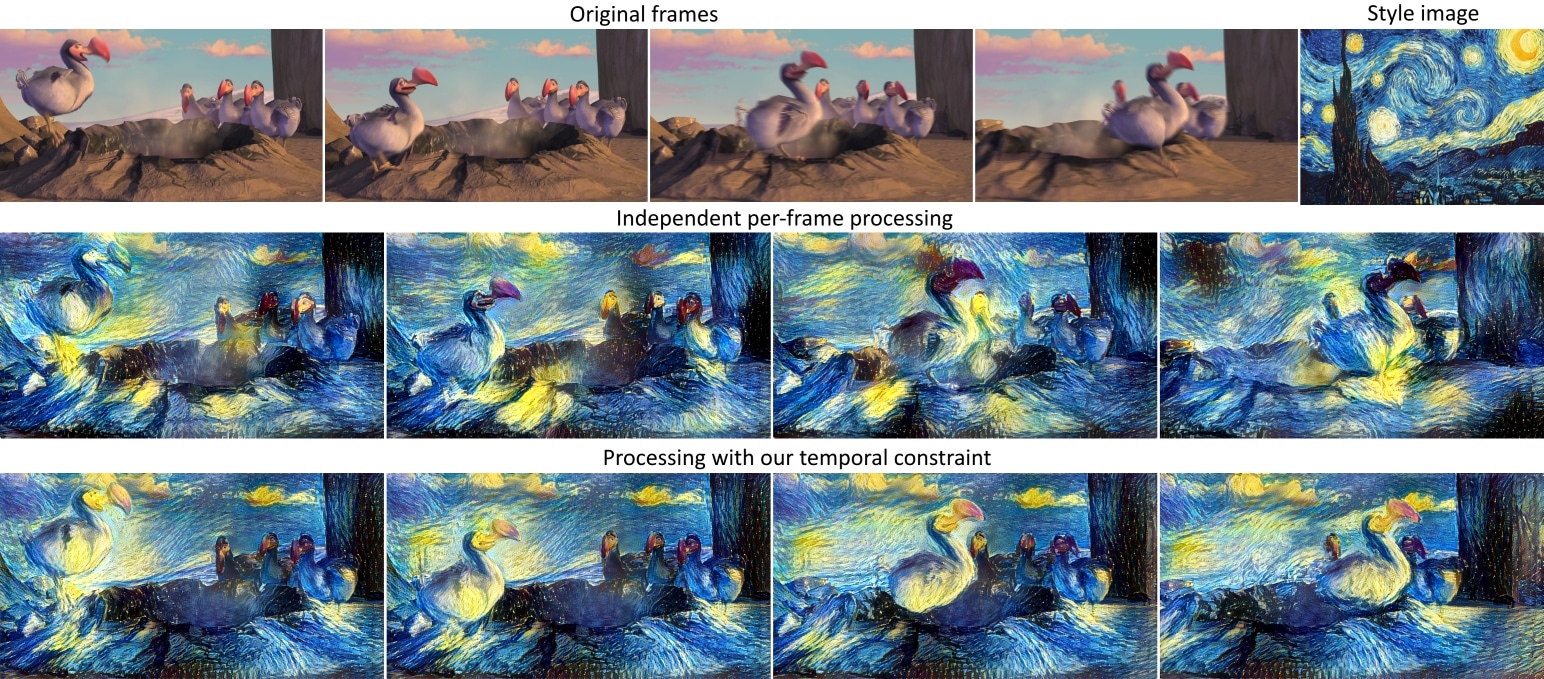

弗赖堡大学博士后 Alexey Dosovitskiy 说:“如果你只是逐帧地应用此算法,那么视频风格会不一致,播放时画面会闪烁。我们所做的就是引入其他限制条件,使视频风格保持一致。”

Dosovitskiy 和其他研究人员通过控制各帧之间的差异来实现视频风格的一致性,做到这一点面临三个主要挑战:

- 屏幕上的角色在场景中移动时,应有一致的风格;

- 不同帧之间的静态组件(例如背景)应在视觉上保持风格一致;

- 角色离开视野后,背景风格应与角色离开前一致。

该团队的算法结合了限制条件来解决这些问题,使连续帧的风格看起来不会有太大差异,还借助长期偶发事件技术实现风格的连续性,即某个区域再次出现时,就会复制更早出现的多幅帧的同一场景的同一区域的图片构成信息。

巧妙地约束深度学习算法,获得更好的动画视频风格一致性。

为使这一复杂流程变为现实,研究人员采用了 NVIDIA GPU。依靠 GeForce GTX TITAN X GPU 的助力,高分辨率视频每帧的艺术风格传递需要 8 至 10 分钟,这种速度是多核 CPU 的 20 倍。

Dosovitskiy 说:“GPU 至关重要,因为这是一个非常耗时的过程。”

该团队还使用了 NVIDIA 的 cuDNN 深度学习软件,得益于该软件较小的内存需求,他们可以针对高分辨率视频进行风格传递。多 GPU 系统可以进一步缩短此流程所需的时间,但即使是这样,也无法达到视频实时艺术风格传递的要求。

目前为止,该团队已同时在直播视频和动画视频中应用了他们的算法。两者皆呈现出优秀的渲染效果,但 Dosovitskiy 认为观众对直播视频的要求更高。

他说: “观众对这种画面闪烁非常敏感,因此在观看视频时,即使出现了十分微小的闪烁情况,观众仍可以察觉到。”

阅读该团队的论文,详细了解他们的工作。

解决无法解决的问题。详细了解 DGX-1,世界上第一款适用于深度学习的盒中超级计算机。