NVIDIA GeForce RTX 5090 D 和 5080 GPU 基于突破性的 NVIDIA Blackwell 架构打造,借助 NVIDIA DLSS 4 技术将帧率提升高达 8 倍,借助 NVIDIA Reflex 2 降低延迟,并借助 NVIDIA RTX 神经网络着色器增强图形保真度。

这些 GPU 旨在加速最新的生成式 AI 工作负载,每秒可完成多达 2,375 万亿次 AI 运算 (TOPS),为 AI 发烧友、游戏玩家、创作者和开发者带来非凡体验。

为了帮助 AI 开发者和发烧友利用这些功能,NVIDIA 在上个月的 CES 展会上推出了适用于 RTX 的 NVIDIA NIM 和 AI Blueprints。NVIDIA NIM 微服务是一套易于使用的预构建容器工具,让开发者和发烧友可以轻松开始使用生成式 AI,快速迭代,并利用 RTX 的强大功能加速 Windows PC 上的 AI。NVIDIA AI Blueprints 是全面的参考工作流,可使用 NIM 加速 AI 应用的开发与部署,构建新一代 AI 体验。

NIM 和 AI Blueprints 已针对 GeForce RTX 50 系列 GPU 进行优化。这些技术无缝协作,帮助开发者和发烧友在 AI PC 上构建、迭代和提供尖端的 AI 体验。

NVIDIA NIM 微服务在 PC 上加速生成式 AI

虽然 AI 模型正在高速发展,但将这些创新成果引入 PC 对许多人来说仍然是一个挑战。在 Hugging Face 等平台上发布的模型必须经过数据管护、适配和量化,才能在 PC 上运行。它们还需要集成到新的 AI API 中,以确保与现有工具兼容,并转换为优化的推理后端,以实现峰值性能。

适用于 RTX AI PC 和工作站的 NVIDIA NIM 微服务通过提供由社区和 NVIDIA 开发的 AI 模型,从而降低此过程的复杂性。这些微服务易于下载并可通过行业标准的 API 进行连接,涵盖了 AI PC 所必需的关键模态。它们还与各种 AI 工具兼容,无论是在 PC、数据中心还是云端,都能提供灵活的部署选项。

NIM 微服务涵盖了在配备 RTX GPU 的 PC 上运行优化模型所需的一切工具,包括针对特定 GPU 的预构建引擎、NVIDIA TensorRT 软件开发套件 (SDK)、用于借助 Tensor Core 加速推理的开源库 NVIDIA TensorRT-LLM 等。

Microsoft 和 NVIDIA 携手合作,在适用于 Linux 的 Windows 子系统 (WSL2) 中支持适用于 RTX 的 NIM 微服务和 AI Blueprints。借助 WSL2,在数据中心 GPU 上运行的 AI 容器现在也可以在 RTX PC 上高效运行,使开发者可以更轻松地跨平台构建、测试和部署 AI 模型。

此外,NIM 和 AI Blueprints 利用了 GeForce RTX 50 系列所基于的 Blackwell 架构的关键创新技术,包括第五代 Tensor Core 和对 FP4 精度的支持。

利用 Tensor Core 提高新一代 AI 性能

AI 的计算要求非常高,需要极强的处理能力。无论是生成图像和视频,还是理解语言以及做出实时决策,AI 模型每秒都要完成数百万亿次数学运算。为了达到这一速度,计算机需要专为 AI 打造的专用硬件。

2018 年,NVIDIA GeForce RTX GPU 引入了专为处理这些密集型工作负载而设计的专用 AI 处理器 Tensor Core,带来了颠覆性的性能。与传统计算核心不同,Tensor Core 旨在通过更快、更高效地执行计算来加速 AI。这一突破性进展帮助 AI 赋能的游戏、创意工具和生产力应用程序成为主流。

Blackwell 架构将 AI 加速提升至全新水平。Blackwell GPU 中的第五代 Tensor Core 可提供高达 2,375 的 AI TOPS,能处理更苛刻的 AI 任务,并同时运行多个 AI 模型。这意味着无论是实时渲染还是智能助手,都能提供更快的 AI 体验,为游戏、内容创作等领域的创新铺平了道路。

FP4——更小的模型,更强的性能

优化 AI 性能的另一种方法是量化,这种技术可以减小模型规模,使模型更快地运行,同时降低内存需求。

FP4 应运而生,它是一种高级量化格式,可以使 AI 模型在尽可能不影响输出质量的情况下更快速、更精简地运行。与 FP16 相比,它将模型规模减小了多达 60%,并将性能提高了一倍以上,而输出质量仅有轻微下降。

例如,Black Forest Labs 的 FLUX.1 [dev] 模型在 FP16 下需要超过 23 GB 的显存,这意味着它只能由 GeForce RTX 4090 D 和工作站 GPU 提供支持。在 FP4 下,FLUX.1 [dev] 仅需要不到 10 GB 的显存,因此可以在更多 GeForce RTX GPU 本地运行。

在 GeForce RTX 5090 D 上采用 FP4 时,只需 5 秒多一点的时间即可生成图像。

FP4 由 Blackwell 架构提供原生支持,因此,在本地 PC 上部署高性能 AI 比以往更轻松。它还集成到 NIM 微服务中,有效地优化了以前难以量化的模型。通过实现更高效的 AI 处理,FP4 有助于为内容创作带来更快、更智能的 AI 体验。

AI Blueprints 为 RTX PC 上的高级 AI 工作流程提供动力

NVIDIA AI Blueprints 基于 NIM 微服务构建,提供经过预封装和优化的参考实现,无论是数字人、播客生成器还是应用助手,都能让高级 AI 驱动项目的开发变得更轻松。

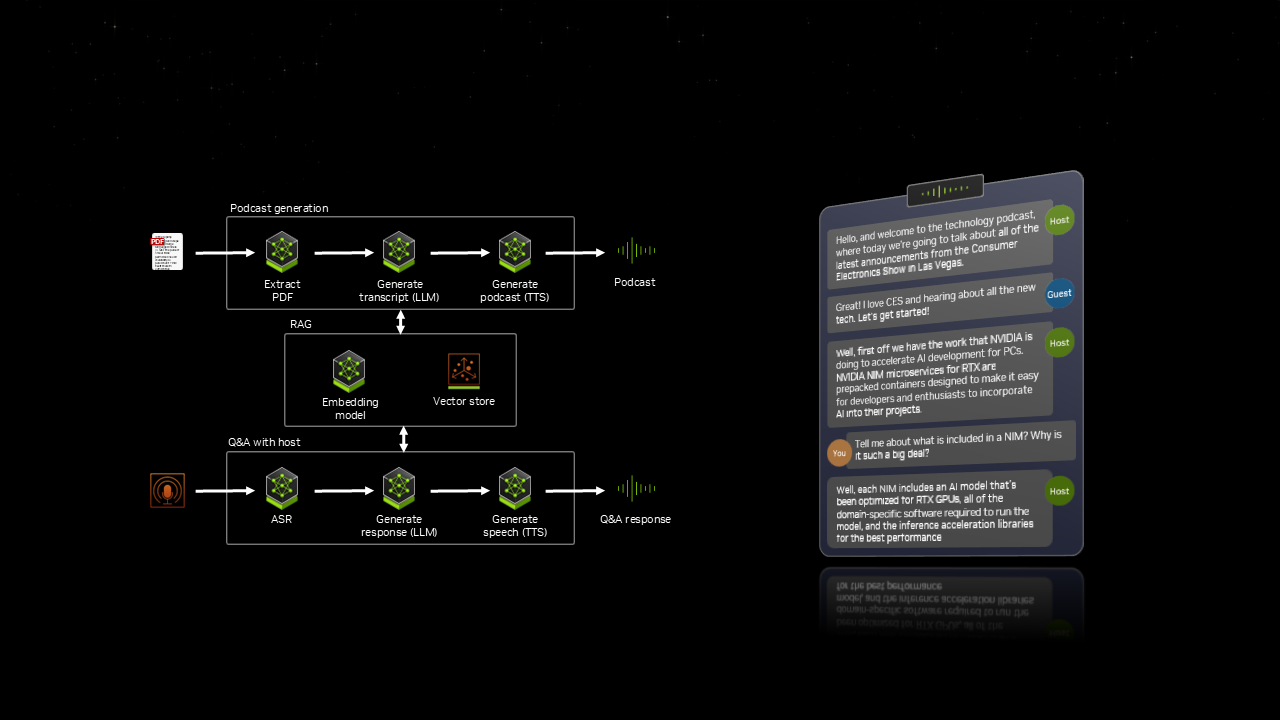

在 CES 上,NVIDIA 展示了 PDF to Podcast blueprint,用户可以使用它将 PDF文件 转换成有趣的播客,后续甚至还能创建 AI 播客主持人问答环节。此工作流程集成了七种不同的 AI 模型,这些模型全部同步运行,以提供动态的、交互式体验。

借助 AI Blueprints,用户可以在 RTX PC 和工作站上快速从试验切换到实际开发 AI。

NIM 和 AI Blueprints 即将登陆 RTX PC 和工作站

生成式 AI 正在突破游戏、内容创作等领域的边界。在 NIM 微服务和 AI Blueprints 出现后,AI 的最新进展不再局限于云,现在已经针对 RTX PC 进行了优化。借助 RTX GPU,开发者和发烧友可以直接在 PC 和工作站本地试验、构建和部署 AI。

NVIDIA NIM 微服务和 AI Blueprints 即将推出,初始硬件支持包括 GeForce RTX 50 系列、GeForce RTX 4090 D 和 4080 以及 NVIDIA RTX 5000 专业 GPU。未来还会陆续提供对其他 GPU 的支持。