美国加利福尼亚州圣克拉拉市 — GTC — 太平洋时间 2022 年 9 月 20 日 — NVIDIA 于今日宣布 NVIDIA H100 Tensor Core GPU 全面投产,NVIDIA 全球技术合作伙伴计划于 10 月推出首批基于开创性 NVIDIA Hopper™ 架构的产品和服务。

H100 于 2022 年 4 月发布,由 800 亿个晶体管组成,并采用了众多开创性的技术,包括强大的全新 Transformer 引擎和 NVIDIA NVLink® 互连技术,以加速最大规模的 AI 模型,如高级推荐系统和大型语言模型,并推动对话式 AI 和药物发现等领域的创新。

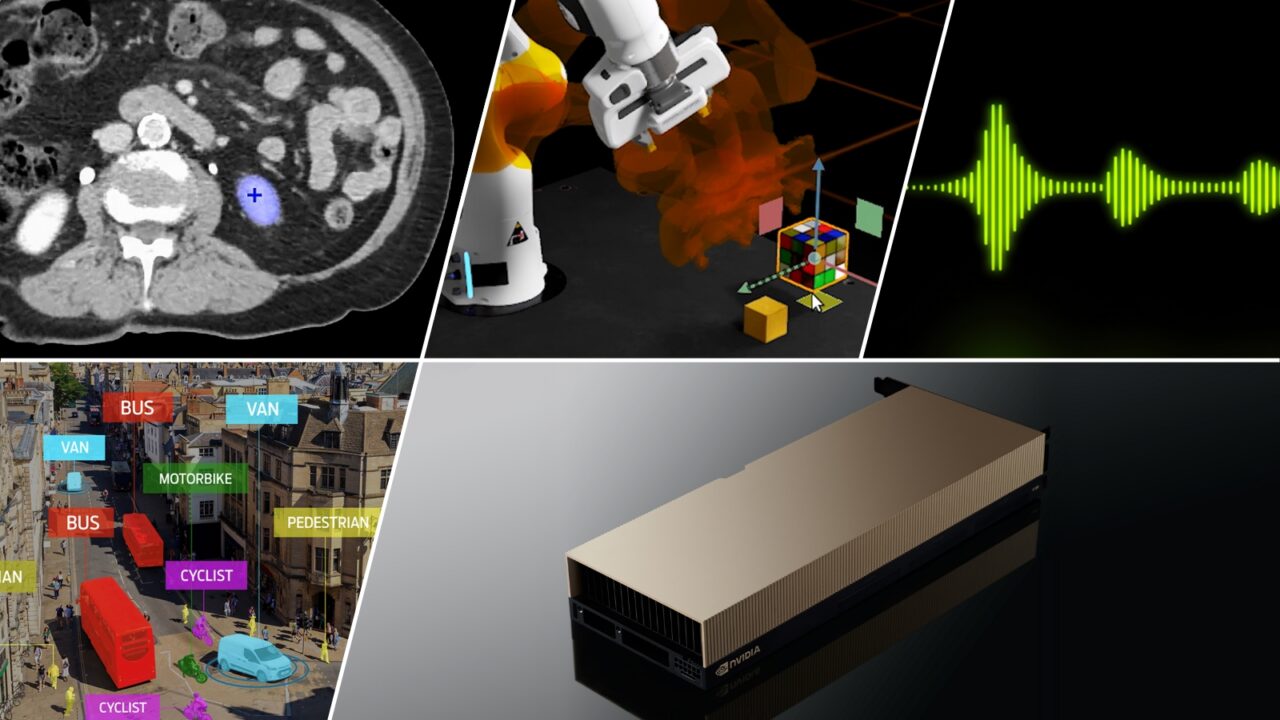

NVIDIA 创始人兼首席执行官黄仁勋表示: “Hopper 是 AI 工厂的全新引擎。它能够处理和挖掘海量数据,训练具有数万亿参数的模型,这些模型将推动基于语言的 AI、机器人、医疗和生命科学领域的进步。Hopper 的 Transformer 引擎将性能提升了一个数量级,使大规模 AI和 HPC 能够为企业和研究人员所用。”

除了 Hopper 的架构和 Transformer 引擎之外,第二代多实例 GPU、机密计算、第四代 NVIDIA NVLink 和 DPX 指令等若干关键性创新也让 H100 GPU 如虎添翼,实现了 NVIDIA 加速计算数据中心平台的又一次飞跃。

用于主流服务器的 H100 现包含为期五年的 NVIDIA AI Enterprise 软件套件许可。这将优化 AI 工作流的开发和部署,确保用户能够获得构建 AI 聊天机器人、推荐引擎、视觉 AI 等所需的 AI 框架和工具。

Hopper 的全球推广

H100 使企业能够削减 AI 的部署成本,相较于上一代,在提供相同 AI 性能的情况下,可将能效提高 3.5 倍,总体拥有成本减少至 1/3,所使用的服务器节点数也减少至 1/5。

对于有意立即尝试这项新技术的客户,NVIDIA 已宣布戴尔 PowerEdge 服务器上的 H100 现可在 NVIDIA LaunchPad 上使用。NVIDIA LaunchPad 为企业提供免费的动手实操实验室,让企业能够接触到最新的硬件和 NVIDIA AI 软件。

NVIDIA DGX™ H100 系统现在也已开始接受客户预定。该系统包含 8 个 H100 GPU,FP8 精度的峰值性能达到 32 PFlops。每个 DGX 系统都包含 NVIDIA Base Command™ 和 NVIDIA AI Enterprise 软件,可实现从单一节点到 NVIDIA DGX SuperPOD™ 的集群部署,为大型语言模型和其他大规模工作负载的高级 AI 开发工作提供支持。

全球领先的计算机制造商所提供的搭载 H100 的系统预计将在未来几周内发货,到今年年底将有超过 50 款服务器型号面市,2023 年上半年还将有数十款型号面市。已在构建系统的合作伙伴包括源讯(Atos)、思科、戴尔科技、富士通、技嘉科技、慧与、联想和超微。

此外,数家全球领先的高等教育和研究机构的新一代超级计算机也将采用 H100。其中包括巴塞罗那超级计算中心、洛斯阿拉莫斯国家实验室、瑞士国家超级计算中心(CSCS)、德州高级计算中心和筑波大学。

H100 走向云端

AWS、谷歌云、Microsoft Azure、Oracle Cloud Infrastructure 将从明年开始率先在云端部署基于 H100 的实例。

Microsoft Azure AI 基础设施总经理 Nidhi Chappell 表示: “我们期待着在 Microsoft Azure的最新 H100 GPU 上实现下一代 AI 模型。借助 Hopper 架构的进步,加之我们在 Azure AI 超级计算方面的投资,我们将能够助力加速全球 AI 的发展。”

Oracle Cloud Infrastructure 产品管理副总裁 Karan Batta 表示: “我们通过为客户提供 NVIDIA 最新的 H100 GPU,帮助他们加速最为复杂的机器学习和 HPC 工作负载。另外,凭借 NVIDIA 的新一代 H100 GPU,我们能够为内部要求严苛的工作负载提供支持,并助力我们共同的客户在医疗、自动驾驶汽车、机器人和物联网领域取得突破。”

NVIDIA 的软件支持

H100 先进的 Transformer 引擎技术可助力企业快速开发精度更高的大型语言模型。随着这些模型的规模不断扩大,其复杂性也在不断提升,有些模型的训练时间甚至长达数月。

为解决这一问题,一些全球领先的大型语言模型和深度学习框架正在 H100 上进行优化,包括 NVIDIA NeMo Megatron、Microsoft DeepSpeed、Google JAX、PyTorch、TensorFlow和XLA。这些框架与 Hopper 架构相结合,能够显著提升 AI 性能,将大型语言模型的训练时间缩短到几天乃至几小时。

欲进一步了解 NVIDIA Hopper 和 H100,请观看 GTC 黄仁勋主题演讲。免费注册 GTC,与 NVIDIA 和行业领导者共襄盛会!