在基于 NVIDIA GPU 的云端服务器支持下,全球每天有数百万人使用聊天机器人。现在这些开创性的工具将出现在搭载 NVIDIA RTX 的 Windows PC 上,以实现本地、快速、信息定制的生成式 AI。

Chat with RTX 技术演示版,现已开放免费下载,用户可在搭载 NVIDIA GeForce RTX 30 系列或更高版本的 GPU(至少 8GB显存)进行本地部署,打造个人专属聊天机器人。

问我一切

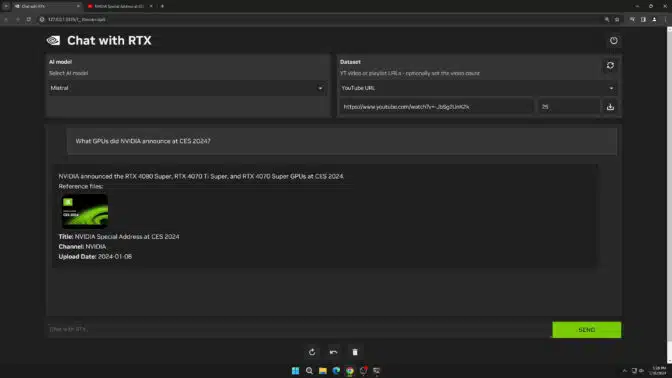

Chat with RTX 借助检索增强生成 (RAG)、NVIDIA TensorRT-LLM 软件及 NVIDIA RTX 加速技术,将生成式 AI 功能引入由 GeForce 赋能的本地 Windows PC。用户可快速轻松地将桌面端上的资料当成数据集,连接到 Mistral 或 Llama 2 这一类开源大型语言模型,以便快速查询与上下文有关的内容。

用户只要输入查询内容即可,无需搜寻笔记或储存的内容。例如用户可以问:「我的合作伙伴推荐拉斯维加斯的哪家餐厅?」Chat with RTX 工具就会扫描用户指向的桌面端资料,并且按照上下文提供答案。

Chat with RTX 工具支持包括 .txt、.pdf、.doc/.docx 和 .xml 在内的多种文件格式。将应用程序指向含有这些资料的文件夹,Chat with RTX 工具就会在几秒钟内将它们载入到资料库中。

用户还能加入 YouTube 视频和播放列表里的信息。在 Chat with RTX 里加入视频网址,用户便能将这些知识与聊天机器人进行整合,进行上下文查询。例如根据最喜欢的旅游 KOL 所发布的视频内容来询问推荐的旅游内容,或是按照顶尖教育资源获取快速教学和操作方法。

Chat with RTX 可以在 Windows RTX PC 和工作站上以本地部署的方式运行,再加上用户的数据还是保留在本地设备装置上,因此能够快速提供查询结果。与依赖云端环境的 LLM 服务不同,Chat with RTX 让用户能够在 PC 桌面端处理敏感资料,无需分享给第三方或是连接到网络。

除了需要配备 GeForce RTX 30 系列或更高版本的 GPU (至少 8GB 显存),使用 Chat with RTX 还需要搭配操作系统 Windows 10 或 11 和最新的 NVIDIA GPU 驱动。

编注:目前 Chat with RTX 中存在一个问题,用户选择不同的安装目录时,会造成安装失败。我们将在日后的版本中修复这个问题。目前用户应使用默认的安装目录(「C:\Users\<username>\AppData\Local\NVIDIA\ChatWithRTX」)。

使用 RTX 开发以 LLM 为基础的应用

Chat with RTX 展现出利用 RTX GPU 加速 LLM 的潜力。这款应用使用 GitHub 上的 TensorRT-LLM RAG 开发者参考项目构建而成。开发者可以使用该参考项目,为 RTX 开发和部署私人以 RAG 为基础的应用,并且由 TensorRT-LLM 进行加速。深入了解如何建立以 LLM 为基础的应用。

深入了解 Chat with RTX。